Ngày 8/4, Ủy ban châu Âu cho biết các công ty làm việc với trí tuệ nhân tạo cần thiết lập các cơ chế trách nhiệm để ngăn chặn nó bị lạm dụng.

Theo các hướng dẫn đạo đức mới cho sử dụng công nghệ AI của EU, các dự án AI phải minh bạch, có sự giám sát của con người và các thuật toán an toàn, đáng tin cậy và phải tuân theo các quy tắc bảo vệ dữ liệu và quyền riêng tư.

Hướng dẫn của EU nhấn mạnh vào cuộc tranh luận toàn cầu về việc khi nào hoặc liệu các công ty có nên đặt mối quan tâm về đạo đức trước lợi ích kinh doanh hay không và các nhà quản lý có thể đủ khả năng để thực hiện các dự án mới như thế nào mà không mạo hiểm phá hủy sự đổi mới.

"Các khía cạnh đạo đức của AI không phải là một tính năng xa xỉ hay một tiện ích bổ sung. Chỉ với sự tin tưởng rằng xã hội của chúng ta hoàn toàn có thể hưởng lợi từ các công nghệ," Cao ủy kỹ thuật số của EU, Andrus Ansip nói trong một tuyên bố.

AI có thể giúp phát hiện các mối đe dọa gian lận và an ninh mạng, cải thiện quản lý rủi ro tài chính và chăm sóc sức khỏe, giải quyết biến đổi khí hậu.

Nhưng nó cũng có thể được sử dụng để hỗ trợ các hoạt động kinh doanh vô đạo đức và các chế độ độc đoán.

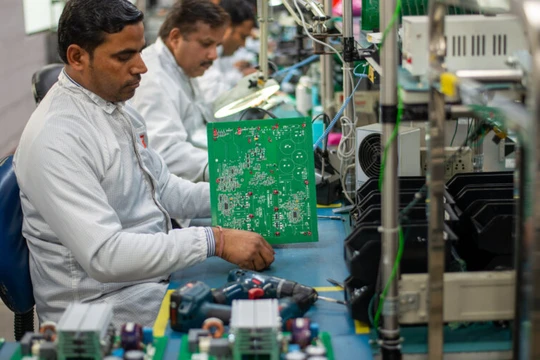

EU năm ngoái với sự giúp đỡ của 52 chuyên gia từ các học viện, cơ quan công nghiệp và các công ty bao gồm Google, SAP, Santander và Bayer đã soạn thảo các nguyên tắc về đạo đức sử dụng công nghệ AI.

Các công ty và tổ chức có thể đăng ký một giai đoạn thử nghiệm áp dụng các quy tắc vào tháng 6, sau đó các chuyên gia sẽ xem xét kết quả và Ủy ban châu Âu sẽ quyết định các bước tiếp theo.

Chủ tịch tập đoàn IBM ở châu Âu Martin Jetter cho biết các hướng dẫn đã đặt ra một tiêu chuẩn toàn cầu cho những nỗ lực thúc đẩy AI có đạo đức và có trách nhiệm./.