LTS: Ngày 10/12, tại Kỳ họp thứ 10, Quốc hội đã biểu quyết thông qua Luật Trí tuệ nhân tạo (AI). Với việc thông qua này, Việt Nam trở thành một trong số ít quốc gia có khung pháp lý toàn diện về AI.

Tuy nhiên để Luật AI thực thi có hiệu quả, cần phải có thêm Khung Đạo đức AI. Bộ Khoa học và Công nghệ vừa đưa ra Dự thảo Khung Đạo đức AI Quốc gia để xin ý kiến các chuyên gia và người dân. Đây là bước đi quan trọng, bởi nếu Luật AI là “phần cứng” thì Khung đạo đức AI chính là “hệ điều hành” định hướng cách chúng ta thiết kế, triển khai và sử dụng AI trong đời sống.

Nhân sự kiện này VietTimes đã có cuộc trò chuyện với chuyên gia Đào Trung Thành, nguyên Phó Viện trưởng Viện Blockchain và Trí tuệ nhân tạo (ABAII), Ủy viên Ban chấp hành Hội Truyền thông số Việt Nam - VDCA.

Thu gọn thành một số nguyên tắc cốt lõi

- Thưa ông, trong một phát biểu mới đây ông cho rằng dự thảo khung đạo đức AI hiện nay đang “nhiều nguyên tắc chung nhưng còn mờ nhạt về tính hành động”. Theo góc nhìn pháp lý, việc đưa ra quá nhiều nguyên tắc có thể tạo ra những rủi ro nào trong thực thi, đặc biệt khi phải chuyển các nguyên tắc mang tính khuyến nghị thành yêu cầu bắt buộc đối với tổ chức, doanh nghiệp?

- Theo tôi, khi khung đạo đức có quá nhiều nguyên tắc, nghe thì rất “đẹp” nhưng lại tạo ra một lớp sương mù trong thực thi.

Về pháp lý, nguyên tắc chỉ nên đóng vai trò định hướng; nếu danh sách quá dài, chồng lấn và thiếu thứ tự ưu tiên, cả cơ quan quản lý lẫn doanh nghiệp đều lúng túng, không biết bắt đầu từ đâu.

Khi mọi thứ đều được coi là ưu tiên, thực chất không có ưu tiên nào cả, và đó là nguồn gốc của rủi ro bất định pháp lý.

Nếu soi kỹ, có ba rủi ro nổi bật.

Một là, doanh nghiệp, đặc biệt nhóm nhỏ và vừa, dễ bị “ngợp” bởi rừng nguyên tắc, dẫn tới hai phản ứng cực đoan: hoặc làm cho có, hoặc ngại áp dụng AI vì sợ sai, đều không tốt cho đổi mới sáng tạo.

Hai là, cơ quan thực thi có thể rơi vào tình trạng “kết luận trước, viện dẫn sau”, cùng một hành vi nhưng mỗi nơi hiểu khác nhau, làm suy yếu tính dự đoán của pháp luật.

Ba là, khoảng cách giữa các khẩu hiệu đạo đức và các quy trình, biểu mẫu, tiêu chí kiểm tra cụ thể không được lấp đầy, khiến khung đạo đức chỉ nằm trên giấy và dần làm giảm niềm tin của chính người phải tuân thủ.

Rủi ro lớn nhất nảy sinh khi ta biến toàn bộ nguyên tắc mang tính khuyến nghị thành nghĩa vụ bắt buộc như nhau cho mọi tổ chức. Khi đó, thay vì quản trị rủi ro dựa trên mức độ tác động của từng hệ thống AI, ta lại có danh sách yêu cầu dàn hàng ngang, làm tăng chi phí tuân thủ vô lý và khiến cơ quan quản lý khó tập trung vào các lĩnh vực nhạy cảm như tài chính, y tế, giáo dục hay an ninh.

Vì vậy, theo tôi, cách tiếp cận hợp lý là thu gọn thành một số nguyên tắc cốt lõi, được gom theo các cụm giá trị rõ ràng. Từ đó mới suy ra nghĩa vụ tối thiểu theo từng mức rủi ro.

Mỗi nguyên tắc khi bước sang “vùng pháp luật” phải trả lời được ba câu hỏi: ai phải làm khác điều gì, ở khâu nào của vòng đời hệ thống AI, và nếu không làm thì trách nhiệm pháp lý ra sao.

Làm được vậy, khung đạo đức vừa giữ vai trò la bàn giá trị, vừa tránh nguy cơ trở thành danh sách khẩu hiệu khó thi hành.

- Ông cũng từng đề nghị tinh gọn 12 nguyên tắc (như dự thảo) thành bộ giá trị cốt lõi 5 - 6 yếu tố, theo ông Việt Nam cần ưu tiên nguyên tắc nào để bảo vệ các quyền cơ bản của con người (quyền riêng tư, quyền được giải thích, quyền không bị phân biệt đối xử)? Và làm thế nào để đảm bảo các quyền này không bị “tối giản hóa” trong quá trình áp dụng?

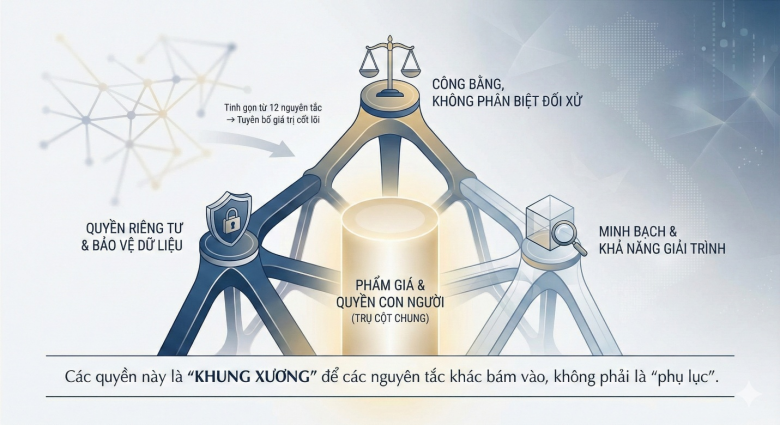

- Khi tinh gọn 12 nguyên tắc, tôi cho rằng thứ tự không phải bài toán kỹ thuật mà là một tuyên bố giá trị.

Việt Nam nên đặt lên hàng đầu trụ cột phẩm giá và quyền con người, với ba nội dung cốt lõi cần nhấn mạnh: Một là quyền riêng tư và bảo vệ dữ liệu cá nhân; Hai là công bằng, không phân biệt đối xử; Ba là minh bạch và khả năng giải trình, gắn với quyền được giải thích khi AI tham gia các quyết định quan trọng.

Đây không phải “phụ lục” mà phải là “khung xương” để các nguyên tắc khác bám vào.

Điều quan trọng không chỉ là ghi tên các quyền này trong khung đạo đức, mà là chuyển chúng thành nghĩa vụ cụ thể.

Với quyền riêng tư, tối thiểu phải có đánh giá tác động dữ liệu, giới hạn mục đích sử dụng và cơ chế xin lại sự đồng ý khi mở rộng mục đích, nhất là với hệ thống rủi ro cao.

Với công bằng, cần kiểm tra sai lệch dữ liệu và mô hình, đồng thời bảo đảm người bị ảnh hưởng có kênh khiếu nại và quyền yêu cầu con người xem xét lại quyết định.

Với quyền được giải thích, không cần “giải thuật từ A đến Z”, nhưng người dân phải biết AI có tham gia quyết định hay không, dựa trên loại dữ liệu nào, và họ có lựa chọn từ chối hay không.

Để tránh việc các quyền này bị “tối giản hóa” khi triển khai, theo tôi cần hai lớp bảo đảm.

Một là, ngay trong Khung đạo đức, phải xác định đây là các quyền không thể thương lượng đối với hệ thống rủi ro cao, đi kèm chỉ báo và checklist (danh sách kiểm tra) cụ thể cho cơ quan nhà nước và doanh nghiệp.

Hai là, khi chuyển sang Luật AI và các nghị định, mỗi quyền phải gắn với quy trình rõ ràng: chủ thể chịu trách nhiệm, khâu đánh giá trong vòng đời hệ thống, cơ chế kiểm toán, và con đường để người dân tiếp cận hoặc khiếu nại. Chỉ khi đó, các quyền cốt lõi mới trở thành thực chất, chứ không dừng lại ở những tuyên ngôn đẹp.

Mô hình ba bước: Map – Measure – Manage

- Mô hình 4 bước ông từng nêu (Govern - thiết lập cơ chế quản trị và trách nhiệm; Map - lập bản đồ hệ thống AI, phân loại rủi ro; Measure - đánh giá tác động và đo lường rủi ro; Manage - giám sát, xử lý sự cố và cải tiến) được xem là cách tiếp cận mang tính quản trị rủi ro toàn diện. Nhưng trong bối cảnh Việt Nam chưa có hành lang pháp lý đầy đủ như Đạo luật Trí tuệ nhân tạo của Liên minh châu Âu (EU AI Act), ông đánh giá khả năng triển khai thực tế của mô hình này ra sao?

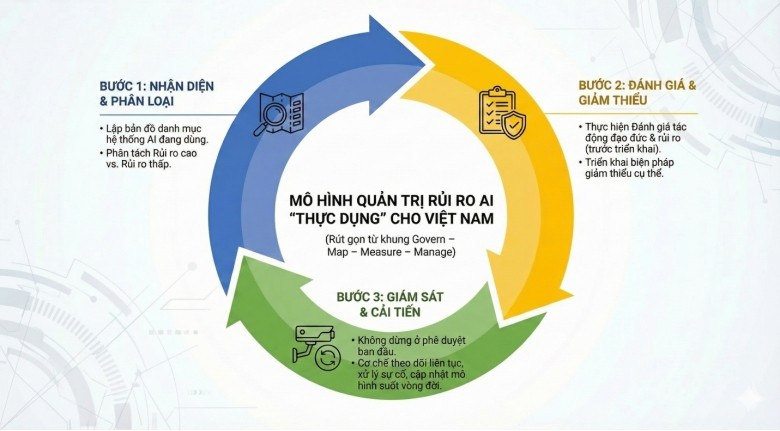

- Khi nói về mô hình “Govern - Map - Measure - Manage”, tôi thường Việt hóa thành ba bước cho dễ nhớ và dễ triển khai.

Bước một là nhận diện và phân loại: cơ quan, doanh nghiệp phải lập bản đồ các hệ thống AI đang sử dụng và xác định đâu là rủi ro cao, đâu là rủi ro thấp.

Bước hai là đánh giá và giảm thiểu: với các hệ thống rủi ro cao cần đánh giá tác động đạo đức và rủi ro trước khi triển khai, kèm theo biện pháp giảm thiểu cụ thể.

Bước ba là giám sát và cải tiến: không dừng ở phê duyệt ban đầu mà phải theo dõi, xử lý sự cố và cập nhật trong suốt vòng đời hệ thống. Đây là phiên bản rút gọn, thực dụng của bốn nhóm hoạt động trong khung NIST (National Institute of Standards and Technology - Khung chuẩn về an ninh mạng, do Viện Tiêu chuẩn và Công nghệ Quốc gia Mỹ đưa ra làm chuẩn).

Trong bối cảnh Việt Nam vừa thông qua Luật về AI, nhưng chưa có một đạo luật đạo đức về AI hoàn chỉnh như EU AI Act, mô hình ba bước này vẫn có thể triển khai ngay dưới dạng chính sách nội bộ và hướng dẫn mềm.

Các lĩnh vực vốn quen với quản trị rủi ro như ngân hàng, viễn thông, y tế hoàn toàn có thể lồng ghép ba bước vào khung ISO, Basel hay các quy trình hiện có mà không cần chờ một bộ luật đầy đủ.

Vấn đề không nằm ở kỹ thuật, mà ở kỷ luật tổ chức và quyết tâm lãnh đạo: có coi AI là rủi ro trọng yếu để “map, đo, quản”, hay chỉ coi nó như một công cụ tiện ích. Nếu chỉ dựa vào tự nguyện, sẽ có vài “ngọn hải đăng” làm rất tốt, nhưng bức tranh chung vẫn loang lổ.

Để mô hình này vận hành quy mô quốc gia, theo tôi cần ba điều kiện pháp lý tối thiểu.

Một là, Luật AI (đã được Quốc hội thông qua) và Nghị định hướng dẫn thực thi luật phải định nghĩa rõ hệ thống AI và cách phân loại rủi ro, làm cơ sở xác định chủ thể bắt buộc phải đi đủ ba bước.

Hai là, cần căn cứ pháp lý yêu cầu đánh giá tác động AI đối với các lĩnh vực rủi ro cao, kèm nghĩa vụ lưu hồ sơ, kiểm toán và báo cáo, để “Measure” trở thành trách nhiệm pháp lý chứ không chỉ là khuyến nghị đạo đức.

Ba là, phải phân vai và gắn trách nhiệm cho cơ quan quản lý, nhà phát triển và bên triển khai, kèm chế tài tối thiểu khi vi phạm, để bước “Manage” không bị biến thành khẩu hiệu.

Khi những mảnh ghép này được luật hóa, mô hình ba bước mới thực sự trở thành “xương sống” của quản trị rủi ro AI tại Việt Nam.

- Vấn đề phân định trách nhiệm giữa “nhà phát triển AI” và “bên triển khai AI” đang là tranh luận lớn toàn cầu. Theo ông, Việt Nam nên thiết lập cơ chế trách nhiệm như thế nào để không xảy ra việc đổ lỗi lẫn nhau khi xảy ra sự cố, đồng thời vẫn đảm bảo tính khuyến khích đổi mới cho các doanh nghiệp phát triển AI trong nước?

- Nếu không phân định rõ trách nhiệm, chúng ta rất dễ rơi vào “trò chơi đổ lỗi”: bên phát triển nói “tôi chỉ bán công cụ”, còn bên triển khai lại khẳng định “tôi tin vào cam kết của nhà cung cấp”.

Việt Nam nên coi đây là chuỗi trách nhiệm chung, không phải “hoặc anh, hoặc tôi”. Vì vậy, luật và các nghị định cần định nghĩa rành mạch ai là nhà phát triển (thiết kế, huấn luyện, cung cấp mô hình, nền tảng) và ai là bên triển khai (tích hợp AI vào quy trình, sản phẩm, dịch vụ), đồng thời yêu cầu mỗi bên chịu trách nhiệm với phần mà họ thực sự kiểm soát.

Cụ thể, một là, nhà phát triển phải chịu trách nhiệm về thiết kế mô hình, dữ liệu huấn luyện, cơ chế an toàn tích hợp sẵn, cùng mức độ minh bạch và tài liệu kỹ thuật đi kèm. Nếu không cung cấp thông tin về giới hạn mô hình, rủi ro đã biết hay khuyến cáo sử dụng, họ không thể trốn tránh trách nhiệm khi sự cố xảy ra đúng ở những điểm đã được cảnh báo rộng rãi.

Hai là, bên triển khai phải chịu trách nhiệm về bối cảnh ứng dụng, cách tích hợp AI vào quy trình, mức độ giám sát con người và việc tuân thủ quy định ngành trong môi trường cụ thể của mình.

Cùng một mô hình, sử dụng cho gợi ý marketing khác hoàn toàn với chấm điểm tín dụng hay chẩn đoán bệnh; phần rủi ro tăng thêm phải thuộc về bên triển khai.

Ba là, với các hệ thống rủi ro cao, Việt Nam nên yêu cầu một dạng "hợp đồng đạo đức và trách nhiệm AI” giữa nhà phát triển và bên triển khai.

Hợp đồng này phải nêu rõ mục đích thiết kế, mục đích không nên sử dụng, cam kết an toàn của nhà phát triển, và các nghĩa vụ bổ sung của bên triển khai như đánh giá tác động, thử nghiệm, giám sát con người, đào tạo người dùng. Khi có sự cố, cơ quan quản lý chỉ cần đối chiếu hợp đồng và hồ sơ đánh giá rủi ro để xác định bên nào không hoàn thành trách nhiệm, tránh tình trạng “ai cũng vô tội”.

- Việc gắn nhãn nội dung do AI tạo ra (watermark – dấu nhận dạng nguồn gốc; metadata – siêu dữ liệu mô tả nội dung; tiêu chuẩn C2PA – chuẩn quốc tế về xác thực nguồn gốc và tính toàn vẹn nội dung số) được xem là công cụ then chốt để chống tin giả và deepfake. Theo ông, nếu muốn đưa công cụ này vào quy định pháp luật hoặc quy chuẩn kỹ thuật quốc gia, Việt Nam cần cân nhắc những yếu tố pháp lý nào để không xâm phạm quyền riêng tư, tự do biểu đạt của người dùng?

- Tôi ủng hộ việc gắn nhãn nội dung do AI tạo ra như một tuyến phòng thủ quan trọng trước tin giả và deepfake, nhưng đây là con dao hai lưỡi.

Nếu thiết kế cẩu thả, cơ chế này có thể bị biến thành công cụ giám sát và kiểm soát phát ngôn, đi ngược lại chính các giá trị mà khung đạo đức AI muốn bảo vệ. Vì vậy, khi đưa watermark, metadata hay chuẩn C2PA vào luật hoặc quy chuẩn kỹ thuật quốc gia, có vài điểm pháp lý không thể bỏ qua.

Trước hết là phạm vi và tính tương xứng. Quy định bắt buộc chỉ nên áp dụng cho các tình huống rủi ro cao như nội dung thời sự – chính trị, quảng cáo bầu cử, hay nội dung liên quan đến danh dự, hình ảnh, giọng nói của cá nhân thật, chứ không nên yêu cầu gắn nhãn mọi sản phẩm sáng tạo cá nhân.

Đồng thời, phải phân biệt rõ trách nhiệm giữa nền tảng lớn và người dùng cá nhân; không thể áp cùng một gánh nặng pháp lý cho một nhà sáng tạo nhỏ và một nền tảng có hàng triệu người dùng. Nếu không giữ được tính tương xứng, cơ chế gắn nhãn rất dễ trở thành rào cản đối với tự do biểu đạt.

Tiếp theo là quyền riêng tư và ẩn danh. Watermark hay metadata có thể vô tình trở thành “dấu vân tay số”, cho phép lần theo hành vi và mạng lưới xã hội của người dùng. Vì vậy, tiêu chuẩn kỹ thuật phải quy định rõ: thông tin gắn kèm chỉ phục vụ minh bạch nguồn gốc nội dung, không chứa dữ liệu cá nhân hay thông tin nhận dạng, trừ trường hợp có căn cứ pháp luật đặc biệt như điều tra tội phạm nghiêm trọng. Đồng thời cần cấm sử dụng cơ chế gắn nhãn để thu thập dữ liệu hàng loạt. Thiết kế phải “privacy by design”, bảo vệ quyền riêng tư ngay từ tầng kỹ thuật.

Một điểm quan trọng khác là bảo vệ tự do biểu đạt. Gắn nhãn chỉ nhằm tăng minh bạch, không phải gắn mặc định nội dung đó với “nghi ngờ” hay “kém tin cậy”. Pháp luật cần khẳng định rằng việc nội dung có yếu tố AI không làm mất đi quyền biểu đạt chính đáng; đồng thời phải có ngoại lệ cho nghệ thuật, trào phúng và sáng tạo cá nhân, miễn không xâm hại quyền, lợi ích hợp pháp của người khác. Nếu nền tảng hạn chế hiển thị dựa trên gắn nhãn, họ phải công khai tiêu chí để tránh “kiểm duyệt mềm”.

Cuối cùng là trách nhiệm và khiếu nại. Pháp luật cần xác định ai có nghĩa vụ gắn nhãn, nhà phát triển công cụ, nền tảng phân phối hay người dùng cuối; cơ chế xử lý khi gắn nhãn sai; quyền của người dùng trong việc yêu cầu sửa, gỡ, giải thích; và trách nhiệm bồi thường nếu việc gắn nhãn sai xâm phạm danh dự hoặc quyền riêng tư.

Lý tưởng nhất là nội luật hóa các chuẩn quốc tế như C2PA để bảo đảm tương thích, đồng thời xây dựng cơ chế khiếu nại, giải trình rõ ràng, giúp người dân không bị “đóng dấu một chiều” mà không có tiếng nói.

Mô hình nhiều tầng và ba ưu tiên chính sách “đột phá”

- Đối với khối doanh nghiệp nhỏ và vừa, vốn chiếm phần lớn nền kinh tế, việc áp dụng khung đạo đức AI có thể trở thành gánh nặng. Theo ông, Việt Nam nên thiết kế các “tier - based obligations” (nghĩa vụ theo cấp độ rủi ro và quy mô doanh nghiệp) ra sao, để vừa đảm bảo tuân thủ tối thiểu, vừa khuyến khích doanh nghiệp áp dụng AI an toàn?

- Tôi cho rằng nếu xây dựng khung đạo đức AI theo kiểu “một cỡ cho tất cả”, doanh nghiệp nhỏ và vừa sẽ là nhóm bị “ngợp” đầu tiên và dễ chọn giải pháp an toàn là… không dùng AI. Vì vậy, nguyên tắc xuất phát phải là: nghĩa vụ gắn với mức độ rủi ro của ứng dụng AI, và gắn với quy mô, năng lực doanh nghiệp, chứ không chỉ dựa trên công nghệ.

Một cửa hàng online dùng AI viết quảng cáo không thể bị đối xử như một công ty tài chính dùng AI chấm điểm tín dụng.

Tôi hình dung một mô hình nhiều tầng, dựa trên hai trục: mức rủi ro của hệ thống (thấp - trung bình - cao) và quy mô doanh nghiệp (siêu nhỏ - nhỏ - vừa - lớn).

Ở tầng thấp nhất, với doanh nghiệp nhỏ dùng AI cho tác vụ rủi ro thấp như tổng hợp văn bản hay marketing, nghĩa vụ nên ở mức tối thiểu nhưng rõ ràng: thông báo khi nội dung do AI tạo ra, tôn trọng quy định dữ liệu cá nhân, có người kiểm tra kết quả trước khi đưa cho khách hàng, tức có kỷ luật nhưng không buộc lập bộ máy tuân thủ phức tạp.

Khi doanh nghiệp, kể cả vừa và nhỏ, dùng AI cho các quyết định tác động lớn như cho vay, tuyển dụng, bảo hiểm hay y tế, họ phải bước lên tầng nghĩa vụ cao hơn.

Tối thiểu gồm ba yêu cầu: đánh giá tác động rủi ro AI với mẫu rút gọn; cơ chế khiếu nại và xem xét bởi con người; và lưu hồ sơ cơ bản về dữ liệu, mô hình, tích hợp để phục vụ truy vết khi có sự cố, nhưng không ép doanh nghiệp nhỏ phải có đội pháp chế hay kiểm toán như tập đoàn lớn.

Đi kèm nghĩa vụ phân tầng phải là hỗ trợ phân tầng: checklist theo ngành, mẫu hợp đồng chuẩn với nhà cung cấp AI, công cụ đánh giá rủi ro trực tuyến, chương trình tập huấn chi phí thấp. Khi doanh nghiệp thấy khung đạo đức giúp giảm rủi ro và bảo vệ uy tín, họ sẽ sẵn sàng áp dụng AI an toàn hơn.

- Trong lộ trình 2026 - 2030, theo ông, đâu là ba ưu tiên chính sách mang tính “đột phá” mà Việt Nam phải làm ngay để chuyển khung đạo đức AI thành công cụ pháp lý - kỹ thuật có thể kiểm tra, chứng nhận và xử phạt? Đặc biệt, nên ưu tiên thiết lập tiêu chuẩn kỹ thuật, khung thử nghiệm (sandbox), hay bộ quy định ràng buộc trách nhiệm?

- Từ nay đến 2030, vấn đề không còn là “có khung đạo đức AI hay chưa”, mà là liệu khung đó có trở thành thứ đo được, kiểm tra được và xử phạt được hay không. Để làm được, Việt Nam cần ba ưu tiên then chốt, như la bàn, thước đo và sân tập cho cả hệ sinh thái AI.

Thứ nhất, phải sớm xác lập bộ quy định ràng buộc trách nhiệm tối thiểu trong Luật AI và các nghị định liên quan. Không có “trần nhà pháp lý” thì mọi tiêu chuẩn kỹ thuật hay sandbox chỉ dừng lại ở khuyến nghị.

Việt Nam cần làm rõ thế nào là hệ thống AI rủi ro cao, ai là nhà phát triển, ai là bên triển khai, và những nghĩa vụ không thể né tránh: đánh giá tác động, lưu vết, gắn nhãn nội dung do AI sinh ra, cung cấp kênh khiếu nại và xem xét bởi con người. Khi trách nhiệm đã được “neo” vào luật, toàn bộ công cụ kỹ thuật và quy trình kiểm tra mới có điểm tựa.

Thứ hai, phải xây dựng hệ sinh thái tiêu chuẩn kỹ thuật và chứng nhận phù hợp với Khung đạo đức AI, biến các giá trị thành thước đo cụ thể.

Nếu nói về minh bạch, công bằng, an toàn thì tiêu chuẩn phải trả lời “đo bằng cái gì”: quản trị dữ liệu, kiểm thử mô hình, khả năng giải trình, watermarking, bảo mật… Việt Nam có thể nội luật hóa các chuẩn quốc tế, công nhận phòng thí nghiệm, đơn vị đánh giá và cấp nhãn chứng nhận cho hệ thống rủi ro cao. Khi đó, khung đạo đức trở thành bộ tiêu chí mà doanh nghiệp phải chứng minh thay vì những lời tuyên bố đẹp.

Thứ ba, cần thiết kế AI sandbox gắn với một số lĩnh vực ưu tiên – nơi thử nghiệm đồng thời đạo đức, tiêu chuẩn và nghĩa vụ pháp lý.

Sandbox không chỉ dành cho doanh nghiệp mà còn là nơi cơ quan quản lý học cách áp dụng khung vào từng ngành, tinh chỉnh quy trình đánh giá tác động, mẫu hợp đồng và phân chia trách nhiệm.

Giai đoạn 2026 - 2030 nên tập trung ở các lĩnh vực rủi ro cao như tài chính, y tế, giáo dục và nội dung số để tạo ra bộ hướng dẫn ngành dễ nhân rộng.

Từ các mô hình quốc tế như OECD, NIST hay EU AI Act, điều Việt Nam cần học là sự nhất quán về giá trị, song tránh “sao chép” máy móc những tầng nghĩa vụ mà doanh nghiệp trong nước khó đáp ứng. Một khung đạo đức hiệu quả phải vừa nói được “ngôn ngữ chung” của thế giới, vừa phản ánh ưu tiên riêng của Việt Nam: bảo vệ người yếu thế, thu hẹp chênh lệch số, tôn trọng quyền con người đi cùng ổn định xã hội và an ninh quốc gia.

Nếu cân bằng được hai vế “quốc tế” và “bản địa”, khung đạo đức AI của Việt Nam mới thực sự sống được trong đời sống công nghệ và quản trị của chúng ta.

- Xin cám ơn ông!

Ông Đào Trung Thành là thạc sĩ viễn thông (Đại học Bách khoa TP HCM), thạc sĩ an ninh mạng (Học viện Quốc gia Viễn thông - Institut National des Télécommunications - Pháp). Ông Thành là chuyên gia về lĩnh vực Viễn thông và Công nghệ Thông tin với hơn 27 năm kinh nghiệm. Ông từng kinh qua nhiều vị trí kỹ thuật và quản lý như Phó giám đốc Trung tâm Hỗ trợ Khách hàng và Quản lý cước - VNPT TP HCM, Phó giám đốc Công ty Tin học Bưu điện (Netsoft) và phụ trách về công nghệ và chiến lược của Tập đoàn MVV Group, giảng viên của Học viện Lãnh đạo MVV Academy. Gần đây, ông giữ vị trí Giám đốc Công nghệ Thông tin (CIO) của Hệ thống Vinschool.

Ông Thành cũng có 12 năm giảng dạy về Mạng máy tính, Bảo mật thông tin và Quản trị kinh doanh tại Cao Đẳng kỹ thuật Sài gòn (Saigon Tech), chi nhánh của Đại học Austin (Houston) tại TP HCM. Ông cũng là đồng tác giả cuốn sách “Hướng nghiệp 4.0” về tác động của Cách mạng công nghiệp lần thứ tư đối với việc hướng nghiệp thế hệ trẻ.