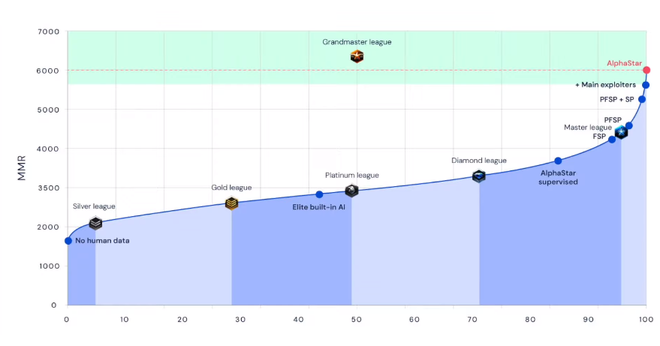

Sáng nay theo giờ Việt Nam, DeepMind công bố một dấu mốc mới trong chặng đường phát triển trí tuệ nhân tạo của họ, chặng đường huấn luyện cho AI chơi thuần thục StarCraft II. Dự án AlphaStar của phòng thí nghiệm phát triển AI trực thuộc Google đã đạt trình độ thượng đẳng, vượt mặt được 99,8% người chơi bằng xương bằng thịt. Báo cáo khoa học mới về AlphaStar đã được đăng tải trên Nature.

Không chỉ vậy, DeepMind còn nói rằng họ đã cố làm cho AlphaStar giống với người chơi thường nhất có thể. Đơn cử, họ cho nó học chơi cả ba đạo trong game (Terran, Protoss và Zerg), đồng nghĩa với tăng độ khó của game lên cho AlphaStar; bên cạnh đó giới hạn lượng bản đồ mà hệ thống AI được phép thấy, đồng thời hạn chế số lần click chuột của AlphaStar lại - chỉ được thực hiện 22 hành động giống nhau mỗi 5 giây chơi, để đạt độ tương đồng với người chơi thực.

Dù bị “nerf” nặng, AlphaStar vẫn đạt được tới trình độ Grandmaster trong StarCraft II, rank của những người chơi siêu phàm nhất. AlphaStar chính thức trở thành hệ thống máy móc đầu tiên đạt được kỳ tích này.

DeepMind coi thành tựu mới của AlphaStar như bằng chứng cho thấy khả năng học của trí tuệ nhân tạo đã đạt tầm cao mới, và rằng thành công hôm nay có thể là nền móng của xe tự lái, robot tự hành và những hệ thống nhận dạng hình ảnh tiên tiến hơn.

“Lịch sử phát triển của ngành trí tuệ nhân tạo đầy rẫy những dấu mốc đạt được nhờ trò chơi. Kể từ ngày máy tính hóa giải được cờ vây, cờ vua và poker, StarCraft đã trở thành thử thách lớn tiếp theo”, David Silver, nhà khoa học nghiên cứu AI thuộc đội phát triển AlphaStar cho hay. “Độ phức tạp của trò chơi điện tử cao hơn cả cờ vua, khi mà người chơi phải điều khiển tới hàng trăm đơn vị lính; phức tạp hơn cả cờ vây, bởi có tận 10^26 khả năng thực hiện mỗi nước đi; và người chơi có quá ít thông tin về đối thủ, đến poker còn biết được nhiều điều về đối thủ hơn”.

Hồi tháng Giêng, nó đánh bại được những game thủ StarCraft hàng đầu nhưng vẫn thua dưới tay Grzegorz “MaNa” Komincz. Kể từ thời điểm bại trận, DeepMind nỗ lực cải thiện AlphaStar suốt từ tháng Giêng cho tới tháng Sáu, rồi “nhận kèo” của mọi game thủ trên thế giới. Những lần giao đấu này diễn ra vào tháng Bảy và tháng Tám vừa qua.

Kết quả làm nức lòng người hâm mộ AlphaStar (và làm những người lo sợ cho tương lai đen tối lo ngay ngáy): AlphaStar đã trở thành game thủ StarCraft II đỉnh cao nhất thế giới, chỉ chưa đạt mức siêu nhân mà thôi. Chỉ có 0,2% số người chơi có thể vượt mặt AlphaStar thời điểm này, nhưng rồi nó sẽ sớm được tối ưu hóa, sẽ sớm chiếm lấy ngôi vị độc tôn.

Dấu mốc lịch sử này cũng ngang với thành công của công ty nghiên cứu AI khác tại San Francisco, OpenAI. Hồi tháng Tư, hệ thống trí tuệ nhân tạo của OpenAI đánh bại được đội tuyển Dota 2 mạnh nhất thế giới (có lẽ máy móc thì miễn nhiễm với trashtalk nên giữ được tinh thần ổn định), sau khi đã thua sát nút hai đội tuyển khác hồi năm ngoái.

Cả hai thành tựu đạt được nhờ trò chơi điện tử của hai đơn vị nghiên cứu AI cho ta thấy khả năng chơi game thượng thừa của máy móc.

Nỗ lực này không chỉ đơn giản là chứng minh được khả năng của AI, mà cho thấy với đủ tài nguyên, thời gian và nỗ lực, một hệ thống trí tuệ nhân tạo sẽ vượt mặt con người ở bất cứ thử thách trí tuệ nào, dù là các trò trí tuệ cổ điển hay trò chơi điện tử. Đây cũng là dấu mốc mới của ngành reinforcement learning - học củng cố, một nhánh đặc biệt của machine learning - máy học, kết hợp sức mạnh tính toán với các cách thức huấn luyện AI như tạo môi trường giả lập để nó tự học bằng data có sẵn.

Cũng như OpenAI, DeepMind huấn luyện AI của mình bằng cách cho nó đối đầu với chính mình, tốc độ xử lý nhanh cho phép trong vài tháng, máy móc có thể có được hàng trăm năm kinh nghiệm. Đó là lý do chúng có thể đương đầu với những kỳ thủ, game thủ gạo cội của những game vô cùng phức tạp.

Vậy nhưng máy móc vẫn chỉ là máy móc, chỉ biết dập khuôn và khó có thể đa nhiệm; chơi cờ vua siêu phàm mấy cũng không chơi được Dota ngay. Đó là bởi thuật toán của AI không dễ thay đổi thế, vì thế mà DeepMind cũng như các đơn vị nghiên cứu AI khác sử dụng reinforcement learning để cho máy móc tự học cách chơi; đó là lý do tại sao chúng lại sinh ra được nhiều chiến thuật “dị” đến vậy, đến mức các người chơi bằng xương bằng thịt cũng phải học theo đôi phần.

“AlphaStar là một người chơi đáng tò mò, không tuân theo luật lệ nào - nó có phản xạ và tốc độ của những người chơi hàng đầu, nhưng lại sở hữu chiến thuật và lối chơi của riêng mình. Cách họ huấn luyện AlphaStar đã tạo ra một lối chơi bất ngờ không tưởng; điều này lại mở ra khía cạnh mới, rằng còn bao nhiêu lối rẽ nữa mà game thủ chưa khai thác hết”, Diego “Kelazhur” Schwimergame, tuyển thủ StarCraft hàng đầu của Brazil, xếp hạng 19 thế giới, nói.

“Mặc dù một vài chiến thuật của AlphaStar trông có vẻ lạ, nhưng nó khiến tôi phải tự hỏi nếu kết hợp tất cả những lối chơi nó tạo ra, liệu chăng đó có phải cách hợp lý nhất để chơi tựa game này”.

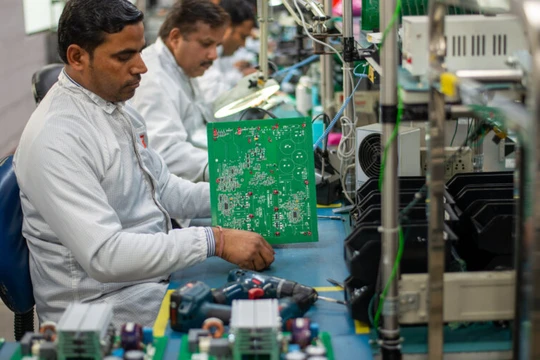

DeepMind không chỉ ứng dụng khả năng máy học siêu phàm vào trò chơi điện tử. Ứng dụng dễ thấy nhất của một hệ thống như vậy sẽ là huấn luyện robot phụ việc nhà, việc trong công xưởng. Nếu tăng khả năng lên nữa, máy móc sẽ lái được ô tô trong thành phố một cách an toàn.

Nhờ có những game phức tạp như StarCraft và Dota, công nghệ trí tuệ nhân tạo mới phát triển nhanh như ngày hôm nay.

Theo Trí thức trẻ

http://ttvn.vn/cong-nghe/tri-tue-nhan-tao-nay-da-choi-starcraft-ii-gioi-hon-988-nguoi-choi-tren-toan-the-gioi-du-bi-nerf-toi-boi-720193110163844444.htm