Tại một phiên điều trần trước Quốc hội Mỹ vào tuần trước, Giám đốc điều hành OpenAI Sam Altman đã đưa ra những lời cảnh báo về sự nguy hiểm của công nghệ mà công ty của ông đã đặt những nền móng đầu tiên.

Ông cảnh báo về các thông tin sai lệch tiềm ẩn và sự thao túng có thể do các công nghệ như chatbot ChatGPT gây ra, đồng thời kêu gọi những ra quy định nghiêm ngặt để kiểm soát mối hiểm họa này.

"AI có thể gây họa cho thế giới”

Cảnh báo của Altman được đưa ra trong bối cảnh các chuyên gia đưa ra quan điểm trái chiều về trí tuệ nhân tạo. Nguy cơ AI vượt qua con người và độc chiếm thế giới đang chuyển dịch từ tiểu thuyết viễn tưởng sang truyền thông đại chúng, gây chia rẽ trong lòng Thung lũng Silicon và với ngay cả những người đang thúc đẩy ứng dụng AI vào cuộc sống.

Những niềm tin cho rằng máy móc có thể vượt qua trí thông minh ở cấp độ con người và quyết định tiêu diệt nhân loại đang thu hút sự chú ý. Một số nhà khoa học được kính trọng nhất trong lĩnh vực này cũng cho rằng máy tính có thể học cách suy nghĩ nhanh hơn con người và dần có xu hướng thao túng chúng ta.

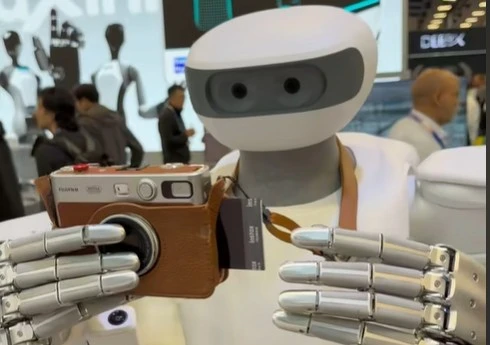

Cuộc tranh luận về AI đang dần nóng lên khi Google, Microsoft và OpenAI tung ra các phiên bản chatbot với khả năng trò chuyện như người thật, cũng như tạo hình ảnh dựa trên văn bản đơn giản.

“Đây không phải là khoa học viễn tưởng”, Geoffrey Hinton, được mệnh danh là cha đỡ đầu của AI, tuyên bố. Gần đây ông đã nghỉ việc tại Google để có thể thoải mái chia sẻ về những rủi ro này. Ông Hinton cho rằng AI thông minh hơn con người có thể xuất hiện trong vòng 5 đến 20 năm tới, so với ước tính trước đó của ông là 30 đến 100 năm.

Cuộc tranh luận bắt nguồn từ những đột phá trong lĩnh vực khoa học máy tính được gọi là học máy trong thập kỷ qua. Công nghệ này có thể giúp phần mềm tạo ra những thông tin mới từ lượng lớn dữ liệu mà không cần hướng dẫn rõ ràng của con người. Công nghệ học máy giờ đã len lỏi vào mọi ngóc ngách đời sống, chúng giúp hỗ trợ các thuật toán truyền thông xã hội, công cụ tìm kiếm và các chương trình nhận dạng hình ảnh.

Vào năm ngoái, OpenAI và một số công ty nhỏ khác đã bắt đầu đưa ra các công cụ sử dụng giai đoạn tiếp theo của công nghệ máy học: AI tổng quát. Được biết đến như những mô hình ngôn ngữ lớn và được đào tạo dựa trên hàng nghìn tỉ bức ảnh và câu từ được lấy từ internet.

Anthony Aguirre, giám đốc điều hành của Future of Life Institute (FLI), một tổ chức được thành lập vào năm 2014 để nghiên cứu các rủi ro hiện hữu đối với xã hội, cho biết các công ty lớn đang chạy đua với nhau để chế tạo những cỗ máy ngày càng thông minh hơn mà ít bị giám sát hơn.

FLI xem xét khả năng AI có thể hủy diệt con người từ năm 2015 và được Elon Musk tài trợ một phần kinh phí. "Nếu AI có khả năng suy nghĩ vượt con người, chúng sẽ tìm cách tự kiểm soát và ngày càng khó ngăn AI vượt khuôn khổ. Đây là vấn đề khoa học viễn tưởng đã thể hiện rất cụ thể", Aguirre nói.

Elon Musk từ lâu đã nói con người nên thận trọng với việc phát triển AI siêu thông minh. Ông cho rằng nó còn nguy hiểm hơn so với đầu đạn hạt nhân. Năm 2020, ông bày tỏ lo sợ một ngày nào đó công nghệ AI Deepmind của Google sẽ thay con người tiếp quản thế giới.

Ý kiến trái chiều

Tuy vậy, nhiều nhà nghiên cứu và kỹ sư khác lại cho rằng sự xuất hiện của AI với khả năng tiêu diệt con người chỉ là mối lo sợ không dựa trên cơ sở thực tế. Điều này đang kéo sự chú ý của thế giới khỏi những đe dọa thật sự mà AI tạo ra, như vấn đề bản quyền, riêng tư cá nhân, an ninh mạng và các chính phủ triển khai vũ khí chết người mà không có sự kiểm soát.

Sara Hooker, Giám đốc của Cohere for AI và là cựu nghiên cứu viên của Google, cho biết: “Trong số các nhà nghiên cứu tích cực trong lĩnh vực này, nhiều người tập trung vào rủi ro hiện tại hơn là rủi ro có thể xảy ra".

Vào năm 2020, nhà nghiên cứu Timnit Gebru và Margaret Mitchell, khi đó còn làm tại Google, đồng xuất bản tài liệu với học giả Emily M. Bender và Angelina McMillan-Major thuộc Đại học Washington, trong đó cho rằng khả năng giao tiếp của mô hình ngôn ngữ lớn (LLM) đang tạo ra mối nguy lớn hơn nhiều so với nỗi lo về việc AI có nhận thức và hủy diệt loài người.

Họ nói LLM là "những con vẹt" dự đoán từ ngữ tiếp theo trong một câu dựa trên phán đoán xác suất, thay vì hiểu nội dung của câu. LLM thường xuyên tung ra những lời phân biệt chủng tộc và giới tính. Gebru cho biết tài liệu này bị Google kiểm soát và cô mất việc vì đề cập tới nó. Mitchell cũng bị sa thải sau đó vài tháng.

"Rất nguy hiểm khi chúng ta tự đánh lạc hướng bằng cách xây dựng những kịch bản thảm họa do AI tạo ra. Chúng ta cần tập trung vào phương thức lạm dụng công nghệ đang được các công ty AI thực hiện, nhất là khi họ đang tìm cách tập trung quyền lực và làm gia tăng bất công xã hội", nhóm nghiên cứu cảnh báo.

Google vào thời điểm đó đã từ chối bình luận về việc sa thải Gebru nhưng cho biết họ vẫn có nhiều nhà nghiên cứu phát triển AI có trách nhiệm và đạo đức.

Cô Sara Hooker nói rằng, không nghi ngờ gì về việc các AI hiện đại rất mạnh, nhưng điều đó không có nghĩa là chúng là mối đe dọa hiện hữu sắp xảy ra.

Theo The Washington Post