Thách thức của quyền riêng tư trong thời đại AI

Dễ thấy rằng, trong thời đại AI thì dữ liệu, đặc biệt là dữ liệu cá nhân đã trở thành “hàng hóa” có giá trị. Bởi lẽ, đó là “nguyên liệu đầu vào” cần thiết cho công nghệ AI, giúp cho AI học được cách tư duy của con người, cho ra kết quả cao hơn.

Bản chất của tiến bộ công nghệ số trong thế kỷ XXI, đó là sự phát triển mạnh của các công nghệ lưu trữ và các loại cảm biến, cho phép thu thập khối lượng dữ liệu đủ lớn từ đời sống xã hội, để xây dựng những “phiên bản số hóa” của các thực thể vật lý trên không gian số. Các “phiên bản số hóa” này có sự chi tiết cần thiết để thực hiện các tính toán của AI. Ví dụ: Thông qua phân tích các mẫu nước đi của các kỳ thủ, AlphaGo sẽ xây dựng được chiến lược chơi cờ vây cho mình. Thông qua dữ liệu thu được từ các cảm biến gắn trên cơ thể, AI có thể dự đoán được bệnh đột quỵ hay các biểu hiện sức khỏe không bình thường. Thông qua các cảm biến và dữ liệu thu thập được trong cửa hàng, Amazon sẽ tính toán được các hành vi của khách hàng khi mua sắm.

Tuy nhiên, nhưng tiện ích mà AI mang lại cũng đi kèm với các nguy cơ, khi các dữ liệu cá nhân bị thu thập trái phép, xâm phạm đến quyền riêng tư, hay bị sử dụng cho những mục đích xấu như thao túng, định hướng dư luận… Giá trị kinh tế của AI khiến cho những dữ liệu cá nhân trở nên hấp dẫn cả giới nghiên cứu lẫn các nhà kinh doanh. Trong nhiều trường hợp, có những người sẵn sàng bất chấp không gian riêng tư của người khác để chiếm đoạt những dữ liệu cá nhân này.

Những dữ liệu cá nhân này sẽ được AI sử dụng để phục vụ việc ra quyết định trong nền kinh tế. Chẳng hạn, các ngân hàng sẽ quyết định cho vay dựa trên phân tích của AI về lịch sử tín dụng của người vay (với độ tin cậy cao hơn các tín dụng viên, và không có nguy cơ bị mua chuộc hay nhầm lẫn); các hãng bảo hiểm sẽ giảm giá cho những khách hàng chấp nhận đeo thiết bị theo dõi sức khỏe - vốn rất nhỏ gọn và tiện dụng.

Xa hơn nữa, đã có những chính phủ nắm trong tay bộ máy cưỡng chế và có tiềm lực tài chính, công nghệ hùng mạnh tham vọng quản lý xã hội thông qua một hệ thống chấm điểm công dân (social credit system) như Trung Quốc. Tiềm năng của AI càng lớn, thì sức hấp dẫn đối với những thế lực muốn xâm phạm đến quyền riêng tư càng lớn.

Đối với Việt Nam, hiện nay chưa có nhiều ứng dụng của AI gắn bó với đời sống con người, song đã chớm hình thành một “thị trường” buôn bán dữ liệu cá nhân, phục vụ cho các hoạt động chào bán nhà đất, xe hơi, bảo hiểm, cho vay tín dụng cá nhân... Trên “thị trường” đó, những thông tin càng riêng tư sẽ lại càng có giá trị, vì thông tin đó phản ánh rõ nét và thực chất nhất cá nhân người sử dụng, phân tích những thông tin riêng tư sẽ cho phép đưa ra kết luận sát với thực tế. Điều đó khiến cho những dữ liệu riêng tư của cá nhân trở thành “mặt hàng” có giá trị và được săn lùng chủ yếu bởi các nhà cung cấp dịch vụ trên internet dưới những vỏ bọc “miễn phí”. Ở mức sơ khai nhất, việc mua bán thông tin cá nhân đã được ứng dụng vào quảng cáo, đã có những công ty chuyên thu thập và mua bán những dữ liệu về địa chỉ, số điện thoại, email… nhằm phục vụ cho quảng cáo. Chẳng hạn, những người sử dụng dịch vụ đặt vé máy bay trực tuyến có thể bị bán dữ liệu cá nhân cho các hãng xe taxi phục vụ tại sân bay, và sẽ nhận được những tin nhắn quảng cáo dịch vụ vào điện thoại di động của mình. Ở mức cao hơn, với sự trợ giúp của khoa học dữ liệu, thông tin về mỗi cá nhân sẽ được phân tích để chỉ ra xu hướng hành vi mua sắm, tiêu dùng … của cá nhân đó, từ đó ứng dụng vào thương mại.

|

| Nhiều hành khách đi máy bay thường phải nhận tin nhắn tiếp thị của các hãng taxi. Ảnh: taxisanbay365.com |

Điều đáng nói, là tại Việt Nam, hành lang pháp lý cho cả hoạt động cho vay ngang hàng lẫn cho việc bảo vệ quyền riêng tư đều đang rất mơ hồ. Ngân hàng Nhà nước Việt Nam hiện chỉ đang trong quá trình xây dựng hành lang pháp lý cho hoạt động cho vay ngang hàng. Trong khi đó, các qui định bảo vệ quyền riêng tư ở Việt Nam lại đang rất sơ khai, nằm rải rác ở một số văn bản pháp lý như Hiến pháp năm 2013 (điều 21), Bộ luật Dân sự năm 2015 (điều 38), và một số văn bản pháp luật chuyên ngành khác … Các quy định này nặng về nguyên tắc, thiếu cơ chế cụ thể cho việc ngăn cản việc thu thập trái phép dữ liệu cá nhân, xâm phạm quyền riêng tư.

Kinh nghiệm quốc tế: Đạo luật Bảo vệ Dữ liệu của Liên minh châu Âu

Nhận thức rõ ràng về những tiềm năng cũng như những nguy cơ mà sự phát triển của AI đem lại trong tương lai, nhiều quốc gia và tổ chức quốc tế đã có những hành động cụ thể để bảo vệ quyền riêng tư trong thời đại công nghệ số. Điển hình là Liên minh châu Âu (EU) với Đạo luật bảo vệ dữ liệu (General Data Protection Regulation - GDPR) có hiệu lực từ ngày 25/5/2018. GDPR đã được 28 quốc gia EU, bao gồm cả Anh phê chuẩn áp dụng.

Về mặt phạm vi áp dụng, GDPR không chỉ bảo vệ quyền lợi của công dân EU mà còn áp dụng cho bất kỳ người nào có sử dụng dịch vụ do một công ty đặt tại Châu Âu cung cấp.

Về định nghĩa, điểm đột phá của GDPR là làm rõ được các khái niệm căn bản liên quan đến dữ liệu cá nhân. Nhận thức được rõ ràng quyền riêng tư rất khó định nghĩa, là “quyền bao trùm các quyền” như một số học giả nhận định, GDPR tiếp cận quyền riêng tư dưới góc độ dữ liệu cá nhân, theo đó:

Dữ liệu cá nhân là bất cứ thông tin nào liên quan đến một thể nhân được xác định hoặc nhận dạng. Dữ liệu cá nhân có thể được liên kết trực tiếp với một người, chẳng hạn như tên, số định danh cá nhân (ID) hoặc dữ liệu vị trí. Dữ liệu cá nhân cũng có thể được liên kết gián tiếp với một người. Điều này có nghĩa là người đó có thể được xác định dựa trên sự kết hợp của một hoặc nhiều yếu tố dành riêng cho một người về bản chất vật lý, sinh lý, di truyền, tinh thần, kinh tế, văn hóa hoặc xã hội.

Xử lý dữ liệu là bất cứ hoạt động hoặc tập hợp các hoạt động được thực hiện trên dữ liệu cá nhân, chẳng hạn như thu thập, ghi âm, tổ chức, cấu trúc, lưu trữ, điều chỉnh hoặc thay đổi, truy xuất, tư vấn, sử dụng, tiết lộ bằng cách truyền, phổ biến hoặc bằng cách khác có sẵn, căn chỉnh hoặc kết hợp, hạn chế, tẩy xóa hoặc phá hủy. Đây là những hành vi chịu sự điều chỉnh của GDPR, trong đó bao gồm việc xử lý dữ liệu bằng công nghệ AI.

Người quản lý dữ liệu được xác định là thể nhân hoặc pháp nhân, cơ quan công quyền, hay các tổ chức khác, một mình hoặc cùng với người khác, xác định mục đích và phương tiện xử lý dữ liệu cá nhân. Đây là những chủ thể có trách nhiệm với dữ liệu cá nhân, và chịu sự điều chỉnh của GDPR.

Một nội dung quan trọng được GDPR luật hóa là quyền được lãng quên (right to be forgotten). Đây là nội dung được phát triển từ thực tiễn xét xử tại các tòa án quốc gia thành viên và Tòa án Công lý của EU về quyền riêng tư. Sự phát triển của mạng internet và những công cụ tìm kiếm mạnh như Google đã đặt ra vấn đề về “quyền được lãng quên” trên Internet.

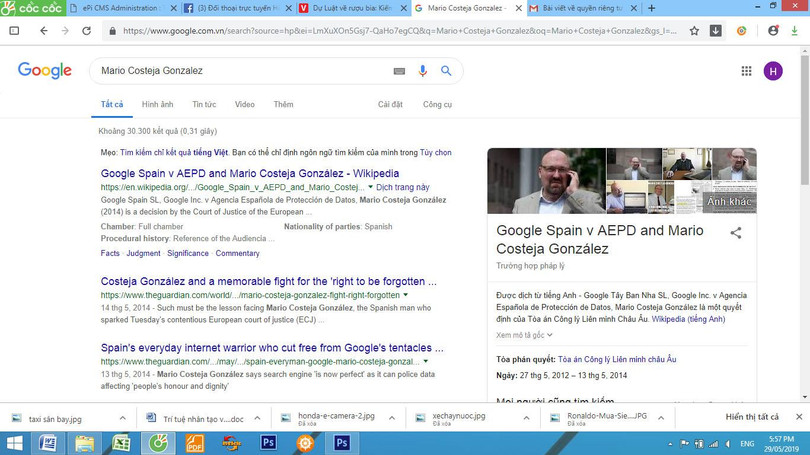

Ví dụ điển hình là trường hợp của một luật sư là Mario Costeja Gonzalez người Tây Ban Nha đã từng bị ngân hàng phát mãi bất động sản để khấu trừ khoản nợ mà ông ta không trả được từ năm 1998. Chuyện này đã được đăng tải trên một tờ báo điện tử. Đã qua 12 năm nhưng câu chuyện đó vẫn được tìm thấy trên Google. Vì thế, Gonzalez đã khởi kiện lên Tòa án Công lý của EU, và đến năm 2014 thì Tòa án đã phán quyết buộc Google phải hủy bỏ kết quả tìm kiếm dẫn đến bài báo nói trên. Nói cách khác, bài báo vẫn nằm trên trang tin điện tử của tờ báo đó, và nếu như bất cứ ai còn giữ đường dẫn vẫn sẽ có thể truy cập vào nội dung này. Nhưng nếu như tìm kiếm theo tên của Mario Gonzalez trên Google thì sẽ không thể tìm ra.

|

| Phán quyết của Tòa án Công lý EU khiến Google phải hủy bỏ kết quả tìm kiếm dẫn đến bài báo về chuyện luật sư Mario Costeja Gonzalez từng bị ngân hàng phát mại bất động sản. Ảnh chụp màn hành |

Ước tính đến nay đã có hàng triệu yêu cầu “quyền được lãng quên” như vậy được gửi đến Google, và 43% đã được chấp thuận. Đây là dấu hiệu đáng mừng cho việc bảo vệ quyền riêng tư, song tiền lệ này cần được nhân rộng ở các quốc gia khác, bằng ràng buộc pháp lý với những nhà cung cấp dịch vụ trên Internet.

Là một đạo luật hoàn thiện, thể hiện trình độ lập pháp cao độ của tinh hoa pháp lý châu Âu, tuy nhiên, GDPR cũng đang đối mặt với nhiều vấn đề trong thời đại AI, điển hình là một số vấn đề dưới đây:

Mâu thuẫn giữa nguyên tắc công bằng và thuật toán thiên vị (algorithmic bias): Có thể lấy ví dụ vấn đề này bằng một nghiên cứu trên tạp chí ProPulica, phân tích các kết quả từ một ứng dụng AI được sử dụng để hỗ trợ việc cho phép bảo lãnh bị cáo, và quyết định mức án tại các tòa án Hoa Kỳ. Ứng dụng này có nhiệm vụ đánh giá khả năng tái phạm của các bị cáo. Nghiên cứu của ProPulica cho rằng các bị cáo người da đen đã bị đánh giá là có rủi ro tái phạm cao gấp đôi so với người da trắng. Nhà phát triển ứng dụng không đồng tình với kết luận nói trên, nhưng từ chối cung cấp các tiêu chí và thuật toán xác định khả năng tái phạm của bị cáo. Như vậy, công chúng và giới nghiên cứu không thể biết được thực sự thuật toán của ứng dụng AI có thiên vị hay không.

Nhận thức được tình huống này, các tác giả của GDPR cho rằng AI có thể không khách quan, nếu như những dữ liệu đầu vào có sự thiên vị. Việc sử dụng dữ liệu cá nhân trong trường hợp này sẽ trái với nguyên tắc công bằng.

Nguyên tắc công bằng đòi hỏi các chủ thể quản lý dữ liệu phải có trách nhiệm chống phân biệt đối xử: Các ứng dụng AI phải sử dụng dữ liệu đầu vào phù hợp, chính xác, không được nhấn mạnh các thông tin liên quan đến nguồn gốc chủng tộc hoặc sắc tộc, quan điểm chính trị, tôn giáo hoặc tín ngưỡng, tư cách thành viên công đoàn, tình trạng di truyền, tình trạng sức khỏe hoặc khuynh hướng tình dục nếu điều này sẽ dẫn đến sự đối xử phân biệt.

Nếu nghi ngờ hoặc tuyên bố rằng việc sử dụng mô hình AI sẽ dẫn đến kết quả không công bằng hoặc phân biệt đối xử, cơ quan chuyên trách về bảo vệ dữ liệu có thể điều tra xem nguyên tắc công bằng có được bảo vệ trong việc xử lý dữ liệu cá nhân hay không. Các cuộc điều tra này có thể bao gồm đánh giá tài liệu làm cơ sở cho việc lựa chọn dữ liệu, kiểm tra cách thuật toán được phát triển và liệu nó có được kiểm tra đúng cách trước khi đưa vào sử dụng hay không.

Mâu thuẫn giữa tái sử dụng dữ liệu trong AI và nguyên tắc giới hạn mục đích: Ví dụ điển hình cho mâu thuẫn này, đó là việc nhiều hãng bán lẻ, hay các ngân hàng, nhà bảo hiểm sử dụng dữ liệu từ mạng xã hội của một người để đánh giá khả năng tài chính, xu hướng mua sắm của người đó.

Nguyên tắc giới hạn mục đích có nghĩa là lý do xử lý dữ liệu cá nhân phải được thiết lập rõ ràng và được xác định khi dữ liệu được thu thập. Mục đích của việc xử lý cũng cần được giải thích đầy đủ cho chủ thể của dữ liệu cá nhân, để người đó có thể đưa ra quyết định một cách sáng suốt.

Tuy nhiên, việc phát triển và ứng dụng AI thường đòi hỏi nhiều loại dữ liệu cá nhân khác nhau mà trong đó có những dữ liệu mà trong một số trường hợp đã được thu thập cho các mục đích khác. Việc tái sử dụng dữ liệu như vậy có thể hữu ích và cung cấp các phân tích chính xác hơn so với những phân tích khả thi về mặt kỹ thuật trước đây, nhưng nó cũng có thể trái với nguyên tắc giới hạn mục đích.

Để giải quyết vấn đề này, GDPR yêu cầu các chủ thể quản lý dữ liệu phải xin phép nếu tái sử dụng dữ liệu cho mục đích mới.

Mâu thuẫn giữa AI và nguyên tắc tối thiểu hóa dữ liệu: Như đã trình bày ở trên, để có thể phát triển AI, cần khối lượng dữ liệu rất lớn. Mặt khác, nguyên tắc tối thiểu hóa dữ liệu của GDPR lại đòi hỏi dữ liệu được sử dụng phải đầy đủ, phù hợp và giới hạn ở những gì cần thiết để đạt được mục đích xử lý dữ liệu. Điều này có nghĩa là chủ thể quản lý dữ liệu không thể sử dụng nhiều dữ liệu cá nhân hơn mức cần thiết và thông tin được chọn phải là liên quan đến mục đích.

Một thách thức khi phát triển AI là có thể khó xác định mục đích xử lý vì không thể dự đoán thuật toán AI sẽ học được gì. Mục đích cũng có thể được thay đổi khi máy học và phát triển. Điều này thách thức nguyên tắc tối thiểu hóa dữ liệu vì rất khó xác định dữ liệu nào là cần thiết.

Tuy nhiên, tối thiểu hóa dữ liệu không chỉ là một nguyên tắc giới hạn số lượng dữ liệu trong phát triển AI. Nguyên tắc này cũng quy định tính tương xứng, trong đó hạn chế mức độ can thiệp vào quyền riêng tư của chủ thể của dữ liệu, mà việc sử dụng dữ liệu cá nhân có thể liên quan. Điều này có thể đạt được bằng cách “làm mờ”, khiến cho không thể xác định các cá nhân có trong dữ liệu cơ bản. Mức độ nhận dạng bị hạn chế bởi cả số lượng và bản chất của thông tin được sử dụng, vì một số chi tiết tiết lộ nhiều hơn về một người so với những người khác. Việc sử dụng mã số định danh hoặc kỹ thuật mã hóa bảo vệ chủ thể dữ liệu giúp hạn chế sự can thiệp này.

Nguyên tắc này cũng buộc các nhà phát triển kiểm tra kỹ lưỡng khu vực dự định áp dụng mô hình AI để tạo điều kiện lựa chọn dữ liệu liên quan cần thiết cho mục đích này. Hơn nữa, nhà phát triển phải xem xét làm thế nào để đạt được mục tiêu theo cách ít xâm lấn nhất đối với các đối tượng dữ liệu. Các đánh giá được thực hiện cần phải được ghi lại, để chúng có thể được trình bày cho cơ quan chức năng trong trường hợp cần thiết.

Về chế tài, mức phạt mà GDPR đưa ra cho các doanh nghiệp vi phạm là rất nghiêm khắc, lên tới 20 triệu Euro hoặc 4% lợi nhuận toàn cầu hàng năm của doanh nghiệp. Đây là mức phạt đáng kể, đủ sức răn đe những doanh nghiệp có ý định vi phạm.

Tương lai nào cho Việt Nam?

Là một đất nước có dân số đông, nền kinh tế đang phát triển nhanh, Việt Nam đã và đang thụ hưởng những thành quả của công nghệ AI trong thời đại số. Tuy nhiên, đi kèm với đó là những thách thức mà các nhà lập pháp phải giải quyết, trong đó có bảo vệ quyền riêng tư và dữ liệu cá nhân.

Trong kho tàng kinh nghiệm lập pháp của các nước trên thế giới về quyền riêng tư, thì GDPR là một đạo luật khá hoàn chỉnh, dự liệu được nhiều biến chuyển của đời sống xã hội thời đại AI. Việt Nam sẽ khó có thể áp dụng nguyên vẹn GDPR, nhưng các nguyên tắc mà GDPR vạch ra sẽ là nguồn tham khảo quan trọng cho hoạt động lập pháp ở Việt Nam, để hình thành hàng lang pháp lý về bảo vệ quyền riêng tư trong thời gian tới.