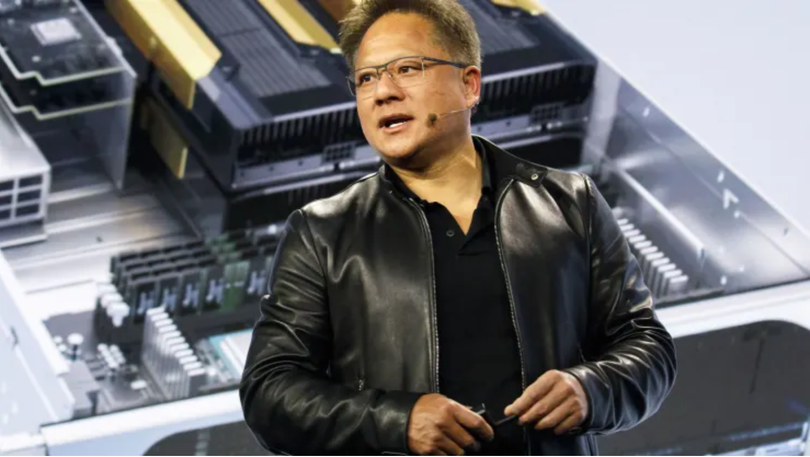

Các card đồ họa tiên tiến nhất của Nvidia đang được bán với giá hơn 40.000 USD trên eBay, do nhu cầu tăng vọt đối với các chip cần thiết để đào tạo và triển khai phần mềm trí tuệ nhân tạo.

Giá cho bộ xử lý H100 của Nvidia đã được nhà tiên phong về trò chơi 3D và cựu giám đốc công nghệ tư vấn Meta - John Carmack ghi nhận trên Twitter. Vào thứ sáu, ít nhất tám mẫu H100 đã được bày bán trên eBay với mức giá từ 39.995 USD đến gần 46.000 USD. Được biết, trong quá khứ một số nhà bán lẻ đã cung cấp thiết bị này với mức giá chỉ khoảng 36.000 USD.

H100 là chip AI mới và mạnh nhất của Nvidia, cũng là bản kế nhiệm của A100 - có mức giá 10.000 USD.

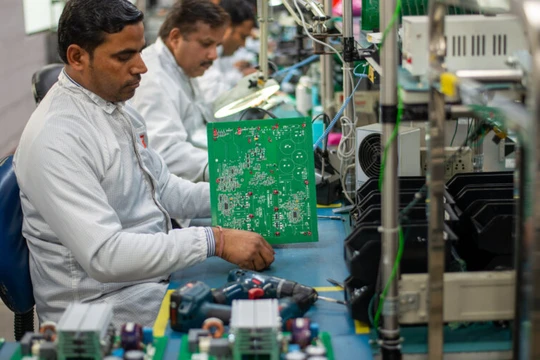

Trong quá trình đào tạo Trí tuệ nhân tạo, GPU có ưu thế hơn CPU bởi khả năng thực hiện tính toán hàng loạt song song. A100 và H100 được các nhà phát triển sử dụng để xây dựng các mô hình ngôn ngữ lớn (LLM), là yếu tố cốt lõi trong các ứng dụng Trí tuệ nhân tạo như ChatGPT. Để xử lý lượng dữ liệu lớn và tạo ra nội dung theo yêu cầu, mỗi doanh nghiệp trí tuệ nhân tạo cần hàng trăm đến hàng nghìn chip như vậy. Họ có thể mua trực tiếp hoặc thuê quyền sử dụng từ các nhà cung cấp dịch vụ đám mây.

Được biết, Microsoft đã chi hàng trăm triệu USD cho hàng chục nghìn chip Nvidia A100 để giúp xây dựng ChatGPT. Hiện tại, Nvidia kiểm soát phần lớn thị trường chip AI.

Nvidia cũng cung cấp một siêu máy tính với tám GPU hoạt động cùng nhau được gọi là DGX. Đầu năm nay, Nvidia đã công bố các dịch vụ mới cho phép các công ty thuê quyền truy cập vào máy tính DGX với giá 37.000 USD mỗi tháng. Với mức giá này, hệ thống sẽ sử dụng bộ vi xử lý A100 của Nvidia.

Nvidia cho biết H100 là con chip đầu tiên được tối ưu hóa cho kiến trúc AI cụ thể làm nền tảng cho nhiều tiến bộ gần đây trong AI, được gọi là máy biến áp. Các chuyên gia trong ngành cho biết các chip mạnh hơn sẽ cần thiết để xây dựng các mô hình thậm chí còn lớn hơn và ngốn nhiều dữ liệu hơn so với các mô hình hiện có.

Theo CNBC