Trong khi công ty Nvidia đang thống trị thị trường đào tạo và triển khai mô hình AI với hơn 90% thị phần. Google tập trung theo hướng thiết kế và triển khai các chip AI, có tên là Bộ xử lý Tensor, hay TPU từ năm 2016.

Google là doanh nghiệp tiên phong lớn về AI và lực lượng kỹ thuật của Google đã có được những tiến bộ quan trọng nhất trong thập kỷ qua. Một số nhà phân tích công nghệ cho rằng, Google đã tụt hậu trong hoạt động thương mại hóa những phát minh của doanh nghiệp.

Trong nội bộ, công ty đang chạy đua để tung ra sản phẩm AI và chứng minh rằng doanh nghiệp kiên quyết không từ bỏ vị trí dẫn đầu, một tình huống “mã đỏ” đang được áp đặt ở công ty, theo bản tin của CNBC trước đó.

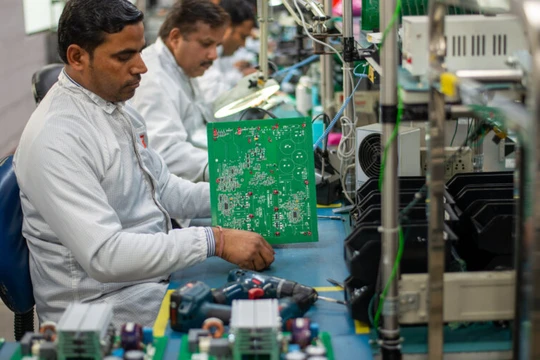

Những mô hình và sản phẩm AI như Bard của Google hay ChatGPT của OpenAI, được chip A100 của Nvidia cung cấp sức mạnh tính toán. Hoạt động của mô hình AI yêu cầu rất nhiều máy tính và hàng trăm hoặc hàng nghìn chip làm việc cùng nhau để đào tạo những mô hình khác nhau với những máy tính chạy liên tục trong nhiều tuần hoặc nhiều tháng. Những mô hình AI tiêu thụ năng lượng rất cao đang là phần nóng nhất của ngành công nghệ điện toán ứng dụng AI.

Ngày 4/4, Google cho biết đã xây dựng một hệ thống với hơn 4.000 TPU, kết hợp với những thành phần tùy chỉnh, được thiết kế để chạy và huấn luyện các mô hình AI. Hệ thống này chạy từ năm 2020, được sử dụng để đào tạo mô hình PaLM của Google, cạnh tranh với mô hình GPT của OpenAI trong hơn 50 ngày.

Các nhà khoa học của Google cho biết, siêu máy tính trên nền tảng TPU của Google, được gọi là TPU v4 “nhanh hơn 1,2 lần–1,7 lần và sử dụng ít năng lượng hơn 1,3 lần–1,9 lần so với máy tính sử dụng chip Nvidia A100. “Hiệu suất, khả năng mở rộng và tính khả dụng khiến siêu máy tính TPU v4 trở thành ngựa ô của những mô hình AI ngôn ngữ lớn”.

Nhưng đến nay, kết quả tính toán TPU của Google không được so sánh với chip Nvidia AI mới nhất, H100, vì sản phẩm TPU mới ra đời gần đây hơn và được sản xuất bằng nút công nghệ tiên tiến hơn, các nhà nghiên cứu Google cho biết.

Kết quả và thứ hạng từ bài kiểm tra toàn ngành chip AI có tên là MLperf được công bố ngày 5/4, giám đốc điều hành Nvidia Jensen Huang cho biết, kết quả kiểm tra chip Nvidia gần đây nhất cho thấy, H100 nhanh hơn rất nhiều so với thế hệ trước.

MLPerf là bộ điểm chuẩn được sử dụng để đánh giá hiệu suất đào tạo và suy luận của các hệ thống máy tính và đám mây. MLPerf được xác định là thước đo hiệu suất khách quan, độc lập cho các khung hoạt động phần mềm, nền tảng phần cứng và nền tảng đám mây dành cho Máy học.

“Điểm nổi bật theo kết quả đánh giá MLPerf 3.0 là kiến trúc Hopper mang lại hiệu suất gấp 4 lần so với A100,” ông Huang viết trong một bài đăng trên blog. “Cấp độ tiếp theo của AI sáng tạo yêu cầu cơ sở hạ tầng AI mới để đào tạo những Mô hình ngôn ngữ lớn (LLM) với hiệu quả năng lượng cao.

Một lượng công năng máy tính rất lớn, cần thiết cho AI có giá rất cao, điều đó khiến nhiều kỹ sư trong ngành tập trung vào nỗ lực phát triển các chip mới, những thành phần như kết nối quang học hoặc kỹ thuật phần mềm nhằm giảm công năng máy tính cần thiết cho đào tạo AI.

Những yêu cầu về công năng máy tính lớn của AI là một lợi ích cho các nhà cung cấp đám mây như Google, Microsoft và Amazon, có thể cho thuê xử lý máy tính theo giờ và cung cấp tín dụng hoặc thời gian tính toán cho các công ty khởi nghiệp để xây dựng và phát triển các mối quan hệ chia sẻ lợi ích. Đám mây của Google cũng bán thời gian xử lý máy tính trên chip Nvidia. Gần đây, Google cho biết Midjourney, một trình tạo hình ảnh AI đã được đào tạo trên chip TPU của doanh nghiệp.

Theo CNBC