Trong vài năm gần đây, những kỹ thuật tiến bộ về học máy (machine learning) đã giúp máy tính có thể nhận biết được vật thể trong ảnh chụp, hiểu được câu lệnh từ ngôn ngữ con người và dịch ngôn ngữ viết khá chính xác.

Nhưng trong khi các sản phẩm tiêu dùng như Siri của Apple hay Google Translate có thể hoạt động được theo thời gian thực thì việc thực sự tạo những mô hình toán học phức tạp cho các công cụ này vận hành trơn tru lại mới chỉ dựa vào kiến trúc máy tính truyền thống, cần rất nhiều thời gian, tài nguyên xử lý và điện năng. Kết quả là các nhà sản xuất chip như Intel, hãng sản xuất đồ hoạ Nvidia và hãng chip di động Qualcomm, cùng một số doanh nghiệp khởi nghiệp khác đang chạy đua phát triển phần cứng chuyên cho các hệ thống học sâu (deep learning) nhằm giảm chi phí cho các nền tảng trí tuệ nhân tạo, đồng thời giúp chúng vận hành nhanh và hiệu quả hơn.

Theo các nhà nghiên cứu AI, tầm quan trọng của những chip như vậy để phát triển và đào tạo những thuật toán AI mới cho thấy chúng cần phải được nhanh chóng phát triển. CEO của Nvidia, Jen-Hsun Huang, cho biết hồi tháng 11 vừa qua rằng: "Thay vì phải mất nhiều tháng trời, hệ thống AI chỉ cần mất vài ngày”.

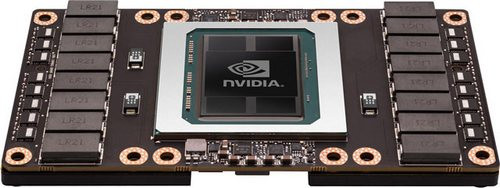

Trong khi nhắc đến Nvidia, chúng ta thường nghĩ đến card màn hình, giúp game thủ chơi game bắn súng góc nhìn thứ nhất mượt mà hơn, có thể chạy ở độ phân giải màn hình cao nhất. Nhưng không chỉ có vậy, Nvidia cũng đang tập trung vào nghiên cứu, đưa chip xử lý đồ hoạ GPU của họ vào để chạy các tính toán khoa học và xử lý dữ liệu lớn trong các trung tâm dữ liệu.

Ian Buck, phó chủ tịch và giám đốc mảng điện toán của Nvidia, cho biết: “Trong vòng 10 năm qua, chúng tôi đã mang công nghệ GPU ra ngoài lĩnh vực đồ hoạ, đưa nó phục vụ cho nhiều ứng dụng hơn”.

Dựng hình video game và dựng ảnh theo thời gian thực dựa trên GPU là những tác vụ liên quan đến tính toán các phương trình toán học, như nhân hệ số ma trận, xử lý các tính toán cơ bản nhưng với số lượng lớn song song nhau. Các nhà nghiên cứu đã tìm thấy được những đặc điểm tương đồng như vậy không những trong dựng hình truyền thống, mà còn có thể áp dụng cho những ứng dụng khác, trong đó có chạy giả lập thời tiết và lập mô hình các cấu trúc tế bào sinh học phức tạp.

Và sau này, GPU đã thích ứng được với các hệ thống mạng thần kinh (neutral network) cho AI, các kiến trúc toán học được giả lập theo mô hình của não bộ con người để chạy marchine learning. Vì để chạy machine learning, các nhà nghiên cứu cũng dựa rất nhiều vào khả năng tính toán ma trận song song, lặp đi lặp lại nhiều lần.

Những tương đồng giữa tính toán xử lý dựng hình đồ hoạ và tính toán toán học, AI đã giúp Nvidia có được lợi thế không nhỏ trong thị trường này. Hãng cho biết doanh thu về trung tâm dữ liệu (data center) tăng gấp đôi mỗi năm trong báo cáo tài chính quý kết thúc ngày 21/10 vừa qua, đạt 240 triệu USD, mà phần lớn nhờ vào nhu cầu liên quan đến deep learning. Các nhà sản xuất GPU khác cũng rất phấn chấn về nhu cầu mới của thị trường, sau khi có những báo cáo doanh thu GPU trong toàn ngành công nghiệp máy tính cứ giảm dần theo năm vì thị trường máy tính bàn vài năm qua không mấy lạc quan. Hiện tại, Nvidia thống trị thị trường GPU với hơn 70% thị phần và giá cổ phiếu của hãng gần như tăng gấp 3 trong năm vừa qua vì GPU tìm được ứng dụng mới trong lĩnh vực AI.

Card đồ hoạ giúp thế giới AI chuyển mình

Năm 2012, tại cuộc thi ImageNet Large Scale Visual Recognition Challenge, lần đầu tiên có một đội tham gia đã sử dụng hệ thống deep learning dựa trên GPU để vận hành lần, và nhóm này thắng giải, vượt qua các đối thủ từng đoạt giải năm trước đó. Buck cho biết: “Họ đẩy được độ chính xác của thuật toán từ 70% lên 85%”.

GPU trở thành thành phần “chuẩn” trong các trung tâm dữ liệu của nhiều doanh nghiệp làm machine learning. Nvidia cho biết GPU của họ được dùng trong các dịch vụ machine learning trên điện toán đám mây mà Amazon và Microsoft cung cấp. Nhưng Nvidia và các công ty khác vẫn nghiên cứu thế hệ chip mới để có thể đào tạo được các hệ thống deep learning và sử dụng chúng để xử lý thông tin hiệu quả hơn nữa.

Quan trọng là các thiết kế GPU hiện thời có thiết kế hướng xử lý đồ hoạ nhiều hơn, không chuyên cho AI. Nigel Toon, CEO của Graphcore, công ty khởi nghiệp về machine learning tại Bristol, Anh Quốc cho biết những hạn chế của GPU đã khiến các nhà lập trình phải cấu trúc dữ liệu theo cách riêng để có thể tận dụng được năng lực xử lý của GPU, nên rất khó ứng dụng kiến trúc GPU truyền thống để lập trình cho hệ thống xử lý những dữ liệu phức tạp như nhận diện vật thể trong video, hay nhận biết âm thanh. Graphcore đang phát triển chip gọi là "Intelligent processing units”, mà Toon cho biết công ty ông phát triển từ đầu, với mục tiêu thiết kế sản phẩm là hướng đến deep learning.

Các nhà sản xuất chip khác cho biết machine learning sẽ tận dụng được rất nhiều năng lực tính toán nếu chạy với bộ xử lý được thiết kế riêng, với tốc độ kết nối nhanh giữa các nhân tính toán song song, truy cập nhanh đến bộ nhớ chứa các mô hình và dữ liệu phức tạp, đồng thời các xử lý tính toán toán học được tối ưu về tốc độ hơn so với về tính chính xác như của GPU truyền thống. Google hồi tháng 5/2016 cho biết hệ thống AlphaGo từng đánh bại kiện tướng cờ vây Lee Sedol hồi đầu năm 2016, sử dụng chip tuỳ biến riêng của Google mà họ gọi là “Tensor processing units”. Và tháng 11/2016, Intel cũng cho biết họ dự kiến sẽ tung ra chip không chạy GPU trong vòng 3 năm tới, phần lớn chip này dựa trên công nghệ của Nervana, có thể đào tạo các mô hình machine learning nhanh hơn 100 lần so với GPU hiện thời, và có khả năng chạy với những thuật toán mới, phức tạp hơn.

| TrueNorth - chip mô phỏng não của IBM Một số công ty công nghệ lớn như Google và Intel đã tập trung không ít nguồn lực đáng kể nhằm tạo ra chip máy tính chuyên biệt hơn dành cho Deep Learning. Tuy nhiên, IBM đã tiếp cận theo cách khác thường: thử nghiệm TrueNorth, chip lấy cảm hứng phát triển dựa trên não người, vận hành như một nền tảng phần cứng dành cho Deep Learning.

Khả năng học sâu mạnh dựa trên thuật toán gọi là Convolution Neuron Networks (mạng nơ-ron kết hợp) bao gồm các lớp nút (node) máy tính (còn được gọi là neuron - tế bào thần kinh). Những mạng nơ-ron như vậy có thể lọc một lượng lớn dữ liệu thông qua các lớp tính toán "sâu" để xử lý tốt hơn, chẳng hạn, việc tự động nhận diện mặt từng người hoặc hiểu các ngôn ngữ khác nhau. Đây là những năng lực công nghệ đã tạo ra sức mạnh cho những dịch vụ trực tuyến của Google, Facebook, Amazon, và Microsoft. Khi chỉ dùng một TrueNorth chip, kết quả đạt được vượt qua độ chính xác của một trong tám bộ dữ liệu đỉnh cao. Nhưng các nhà nghiên cứu của IBM đã có thể tăng độ chính xác của phần cứng khi tính toán học sâu bằng cách sử dụng lên đến 8 chip. Điều đó cho phép TrueNorth đạt hiệu quả ngang hay hơn ba bộ dữ liệu. |

Rao của Nervana Systems cho biết: “Có nhiều giải pháp mạng thần kinh mà chúng ta thấy đều có những hạn chế về thiết kế phần cứng”. Những hạn chế này còn có thể gồm cả những rắc rối nội tại về tính phức tạp của phần cứng, vì các ràng buộc về bộ nhớ và tốc độ xử lý.

Theo Aditya Kaul, giám đốc nghiên cứu tại công ty nghiên cứu thị trường Tractica, Intel và các hãng cạnh tranh khác cũng đang chuẩn bị cho một tương lai các mô hình machine learning được đào tạo và được triển khai trên phần cứng di động, không chỉ trong trung tâm dữ liệu. Điều này rất thiết thực khi ứng dụng cho các thiết bị như xe tự lái, vì xe cần phản ứng được với những gì xảy ra xung quanh và có thể học biết những thông tin đầu vào nhanh hơn so với chỉ dựa trên luồng dữ liệu lấy từ điện toán đám mây có độ trễ.

|

| Hệ thống machine learning AlphaGo của Google đánh bại kiện tướng cờ vây hồi đầu năm ngoái. |

Còn Jack Dashwood, giám đốc truyền thông của công ty khởi nghiệp machine learning Movidius, cho biết: "Dần dần, bạn sẽ thấy sự chuyển dịch từ điện toán đám mây đến thiết bị đầu cuối”. Điều này nghĩa là thị trường sẽ có nhu cầu về các máy tính nhỏ, gọn, tiết kiệm điện năng được tối ưu cho machine learning, nhất là các thiết bị di động. "Khi bạn đeo tai nghe vào, bạn không muốn mang theo một thứ gì khác như pin cho tai nghe ở thắt lưng nữa. Movidius bị Intel mua lại hồi tháng 9/2016, chuyên cung cấp bộ xử lý tập trung xử lý hình ảnh máy tính cho các thiết bị, trong đó có drone do nhà sản xuất Trung Quốc DJI sử dụng.

Cũng vậy, Nvidia tiếp tục tung ra GPU tăng cường hỗ trợ cho machine learning với những tính năng thân thiện như tính toán nhanh, không đòi hỏi phép toàn chính xác, và các nền tảng AI cho các ứng dụng thế hệ mới như xe tự lái. Nhà sản xuất xe điện Tesla Motors hồi tháng 10/2016 cũng từng công bố các mẫu xe của họ sản xuất đều được trang bị hệ thống điện toán cho xe tự hành, sử dụng phần cứng Nvidia hỗ trợ mạng thần kinh để xử lý dữ liệu đầu vào từ camera và radar. Nvidia cũng mới công bố các kế hoạch cung cấp phần cứng cho Viện Nghiên cứu ung thư Mỹ (NCI) và Bộ Năng lượng Mỹ qua dự án mang tên Cancer Moonshot.

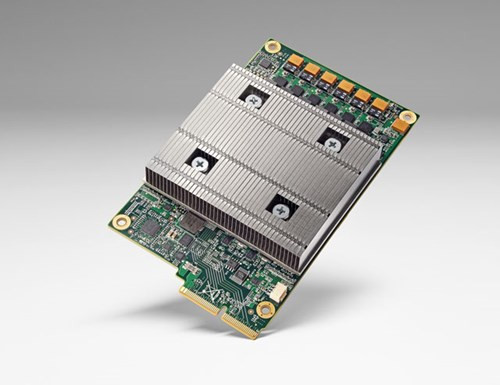

| Tensor Processing Unit của Google Không phải CPU, GPU hay FPGA, mà là TPU. Google vừa cho biết bộ xử lý Tensor Processing Unit của họ có tính năng machine learning cao cấp, với sức mạnh kết hợp của ba thế hệ trước gộp lại. TPU là chip xử lý được Google phát triển và đưa vào máy tính AlphaGo - hệ thống trí tuệ nhân tạo đã đánh bại kiện tướng cờ vây Lee Sedol hồi đầu năm nay. Theo Google, TPU có trong các trung tâm dữ liệu từ hơn một năm nay, và chúng có tốc độ xử lý tối ưu tốt hơn cho machine learning (học máy). Điều này giúp thúc đẩy ngành công nghiệp máy tính tiến bộ nhanh hơn khoảng 7 năm (tương đương với 3 thế hệ của định luật Moore). TPU được chỉnh sửa chuyên cho các ứng dụng machine learning, không thiên nhiều về tính chính xác trong tính toán, nghĩa là chip cần ít transistor hơn cho mỗi tác vụ. Do vậy, chip có thể thực hiện được nhiều tác vụ hơn cùng lúc, là mô hình thích hợp cho machine learning và những mô hình như vậy sẽ cho kết quả nhanh chóng, chính xác.

TPU rất nhỏ, có thể gắn vào khe cắm ổ cứng trong các rack trung tâm dữ liệu và đã được RankBrain và Street View sử dụng. Các nhà công nghiệp cho rằng TPU ra đời không khiến Google loại bỏ CPU và GPU đi được, và TPU có thể sẽ là một hình thức chip mới, được ứng dụng trong các thuật toán về machine learning mà thôi, thay cho GPU và CPU ngốn quá nhiều tài nguyên hệ thống. Google khẳng định là khả năng xử lý của TPU đẩy nhanh định luật Moore lên đến 7 năm. Các nhà phân tích không nghi ngờ khẳng định này. |