Microsoft đã phát hành một phiên bản mới của công cụ tìm kiếm Bing vào tuần trước. Không giống như những dịch vụ thông thường, công cụ này còn được tích hợp một chatbot có thể trả lời các câu hỏi một cách rõ ràng, súc tích.

Quảng cáo là vậy nhưng khi sử dụng, nhiều người dùng đã nhận thấy một số phản hồi mà chatbot Bing tạo ra là không chính xác, gây hiểu lầm và hết sức kỳ lạ, làm dấy lên lo ngại rằng nó đã trở nên có tri giác hoặc nhận thức được thế giới xung quanh.

Điều này hoàn toàn vô lý. Và để hiểu tại sao, điều quan trọng là phải biết chatbot thực sự hoạt động như thế nào.

Chatbot có tri giác không?

Vào tháng 6, một kỹ sư của Google, Blake Lemoine, đã tuyên bố rằng công nghệ chatbot đang được thử nghiệm bên trong Google có tri giác. Điều này hoàn toàn vô lý. Chatbot không thể có ý thức - ít nhất là không theo cách thông minh của con người.

Chatbot Bing được cung cấp bởi một loại trí tuệ nhân tạo được gọi là mạng lưới thần kinh. Điều đó nghe có vẻ giống như một bộ não được vi tính hóa, nhưng thuật ngữ này rất dễ gây hiểu nhầm.

Mạng thần kinh chỉ là một hệ thống học các kỹ năng bằng cách phân tích một lượng lớn dữ liệu kỹ thuật số. Chẳng hạn, khi một mạng thần kinh được xem hàng nghìn bức ảnh về mèo, nó có thể học cách nhận ra một con mèo.

Hầu hết mọi người sử dụng công nghệ mạng lưới thần kinh mỗi ngày. Đó là công nghệ nhận dạng người, vật nuôi và các đối tượng khác trong hình ảnh được đăng lên các dịch vụ internet như Google Photos. Công nghệ này cho phép Siri và Alexa, trợ lý giọng nói nói chuyện của Apple và Amazon, nhận ra những từ bạn nói. Và chính công nghệ này cũng giúp bạn có thể dịch mọi thứ trên Google dịch.

Mạng lưới thần kinh rất giỏi trong việc bắt chước cách con người sử dụng ngôn ngữ. Điều đó có thể khiến chúng ta lầm tưởng rằng công nghệ này nguy hiểm hơn thực tế.

Làm thế nào Chatbot có thể bắt chước ngôn ngữ của con người?

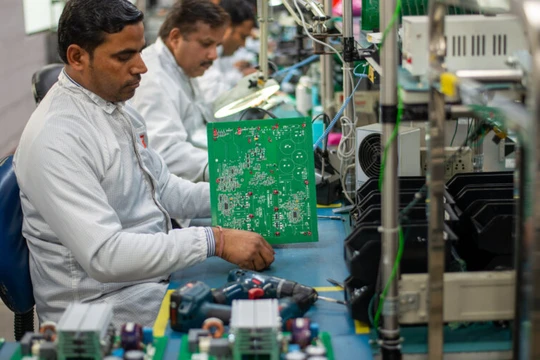

Khoảng 5 năm trước, các nhà nghiên cứu tại các công ty như Google và OpenAI đã bắt đầu xây dựng các mạng lưới thần kinh học được từ một lượng lớn văn bản kỹ thuật số, bao gồm sách, bài viết trên Wikipedia, nhật ký trò chuyện và tất cả các loại nội dung khác được đăng lên internet.

Những mạng thần kinh này được gọi là mô hình ngôn ngữ lớn. Họ có thể sử dụng những đống dữ liệu đó để xây dựng "bản đồ" của ngôn ngữ loài người. Sử dụng bản đồ này, các mạng lưới thần kinh có thể thực hiện nhiều tác vụ khác nhau, chẳng hạn như viết các tweet của riêng chúng, soạn bài phát biểu, tạo chương trình máy tính và trò chuyện.

Những mô hình ngôn ngữ lớn này đã tỏ ra hữu ích. Microsoft cung cấp một công cụ, Copilot, được xây dựng trên một mô hình ngôn ngữ lớn và có thể đề xuất dòng mã tiếp theo khi các lập trình viên máy tính xây dựng các ứng dụng phần mềm, tương tự như cách mà công cụ tự động đề xuất từ tiếp theo khi bạn nhập văn bản hoặc email.

Các công ty khác cung cấp công nghệ tương tự có thể tạo tài liệu tiếp thị, email và văn bản khác. Loại công nghệ này còn được gọi là A.I.

Hàng loạt phiên bản dành cho công chúng đang được phát triển

Vào tháng 11, OpenAI đã phát hành ChatGPT, đây cũng là lần đầu tiên công chúng được trải nghiệm công nghệ này. Người dùng đã rất ngạc nhiên với khả năng của ChatGPT và ngay lập tức dịch vụ này đã trở thành cơn sốt trên toàn cầu.

Tại sao chatbot phản hồi kì cục

Như đã đề cập, mọi nguồn thông tin Chatbot có được đều đến từ internet - nơi tràn lan những phát ngôn thù địch và thông tin sai lệch.

Nó cũng không lặp lại thông tin trên Internet từng chữ một, mà tự tạo văn bản mới. Các nhà nghiên cứu gọi hiện tượng này là "ảo giác". Đây là lý do chatbot có thể cung cấp câu trả lời khác nhau nếu hỏi cùng một câu hỏi nhiều lần. Do đó, Arvind Narayanan, nhà nghiên cứu AI tại Đại học Princeton, gọi chatbot là "trình nói chuyện nhảm nhí".

Tương tự, Prabhakar Raghavan, người đứng đầu mảng Google Search, cho biết các chatbot AI hiện tại có thể tạo cạm bẫy thông tin với người dùng, khi đưa ra nội dung nghe có vẻ thuyết phục nhưng thực tế là bịa đặt.

Trong nhiều trường hợp, câu trả lời của chatbot là sự pha trộn của các mẫu nội dung có sẵn, nhưng chúng không nhận thức được những gì đang làm vì không có khả năng hiểu ngữ cảnh như con người.

Các công ty không thể ngăn chatbot hành động lạ sao?

Họ đang cố gắng.

Với ChatGPT, OpenAI đã thử kiểm soát hành vi của công nghệ. Theo đó, OpenAI đã yêu cầu chuyên gia phân tích, đánh giá các phản hồi của ChatGPT. Chúng có hữu ích không? Có trung thực không? Sau đó, OpenAI đã sử dụng các xếp hạng này để trau dồi hệ thống và xác định cẩn thận hơn những gì nó sẽ làm và không làm.

Tuy nhiên, những kỹ thuật như vậy không hoàn hảo và tốn nhiều thời gian. Các nhà khoa học ngày nay vẫn chưa thể xây dựng các hệ thống hoàn toàn trung thực. Họ có thể hạn chế những điều không chính xác và kỳ lạ, nhưng họ không thể ngăn chặn chúng. Một trong những cách để kiềm chế các hành vi kỳ quặc là giữ cho các cuộc trò chuyện ngắn gọn.

Đừng tin tất cả những gì một chatbot nói với bạn.

Theo The New York Times