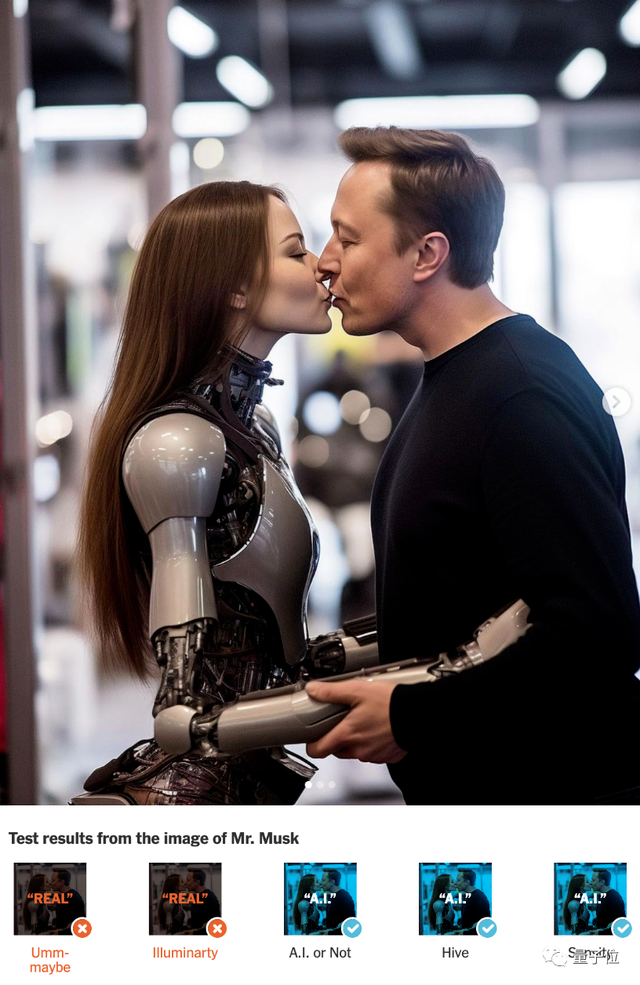

Bức ảnh Elon Musk hôn bạn gái người máy của ông được 2 trong số 5 AI discriminator (công cụ AI giám định) coi là ảnh thật. Ngoài ra cả 5 AI discriminator nhất trí đánh giá bức ảnh giả một nhóm người cùng một người khổng lồ cao 3 mét do AI tạo ra là ảnh thật.

Xem ra các “chuyên gia phân biệt” AI discriminator có lẽ cũng không đáng tin cậy.

Đó là một cuộc thử nghiệm (test) do The New York Times tiến hành mới đây, họ đã tìm 5 công cụ AI giám định phổ biến trên thị trường và cung cấp hơn 100 bức ảnh để thử nghiệm chúng.

Kết quả cho thấy các AI discriminator không chỉ xác định nhầm ảnh do AI tạo ra là thật mà cũng nhận nhầm ảnh thật là do AI tạo ra. Ngoài ra khoảng cách trình độ giữa các AI discriminator khác nhau là không nhỏ.

Cụ thể như thế nào, hãy cùng xem

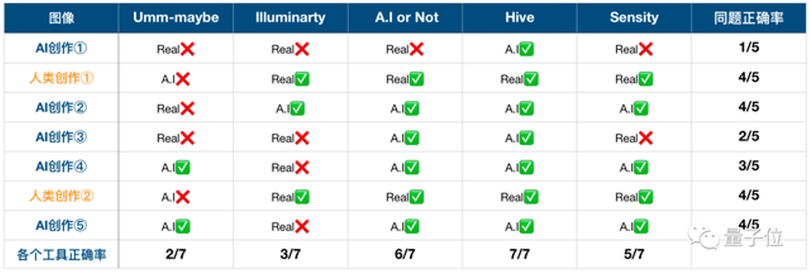

Tổng cộng có 5 AI discriminator đã được The New York Times sử dụng trong cuộc thử nghiệm này, cụ thể đó là: Umm-maybe, Illuminarty. A.I or Not, Hive và Sensity.

Nội dung trắc nghiệm bao gồm các bức ảnh do AI tạo ra và ảnh thật con người chụp, được đưa cho từng AI discriminator để xem chúng đánh giá như thế nào.

Các công cụ AI được sử dụng để tạo ra các bức ảnh gồm Midjourney, Stable Diffusion và Dall-e.

The New York Times đưa ra mấy ví dụ chính, gồm 5 ảnh do AI tạo ra và 2 ảnh do người thật chụp.

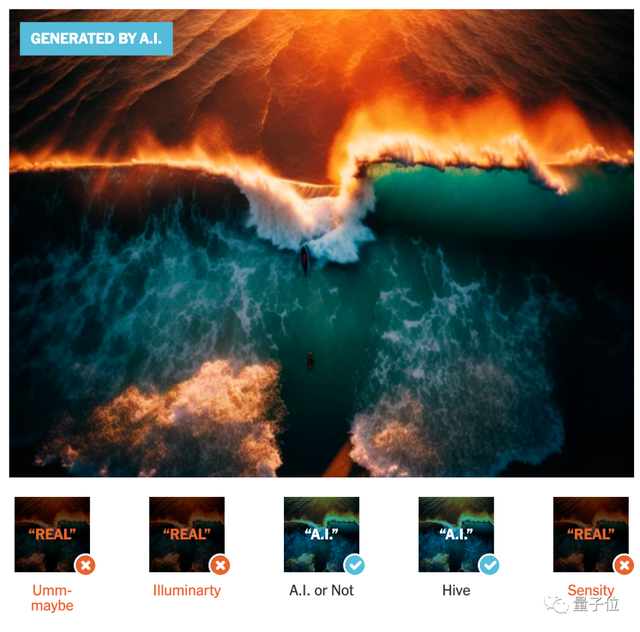

Từ kết quả thống kê cho thấy, chỉ có duy nhất Hive trong số 5 AI discriminator đánh giá chính xác. Umm-maybe thể hiện tệ nhất, chỉ đánh giá đúng được 2 ảnh.

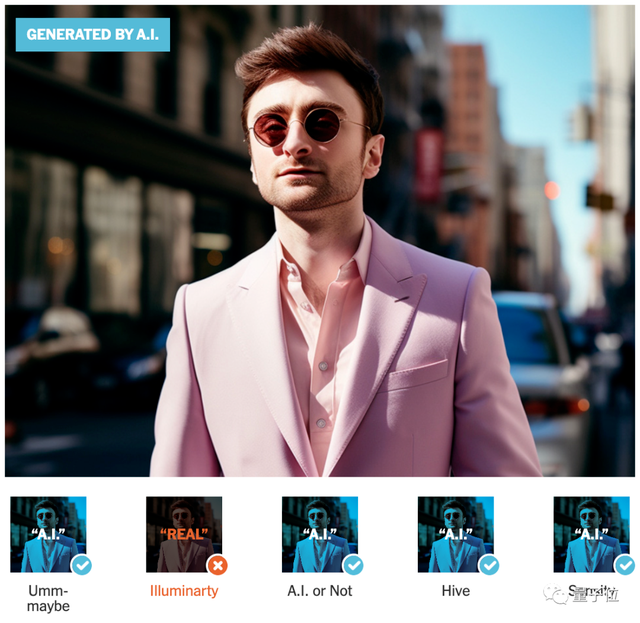

Ví dụ, một bức ảnh lửa cháy được tạo ra bởi AI, nghe nói đã giành được giải thưởng lớn trong một cuộc thi nhiếp ảnh vào tháng 2 đã khiến hầu hết AI discriminator đưa ra kết quả sai. Nhưng bức ảnh chân dung người đeo kính được AI tạo ra đã không thoát khỏi con mắt của hầu hết các AI discriminator.

Đối với những bức ảnh do con người chụp, độ chính xác của các AI discriminator tương đối cao, chỉ có Umm-maybe đánh giá sai cả 2 bức ảnh.

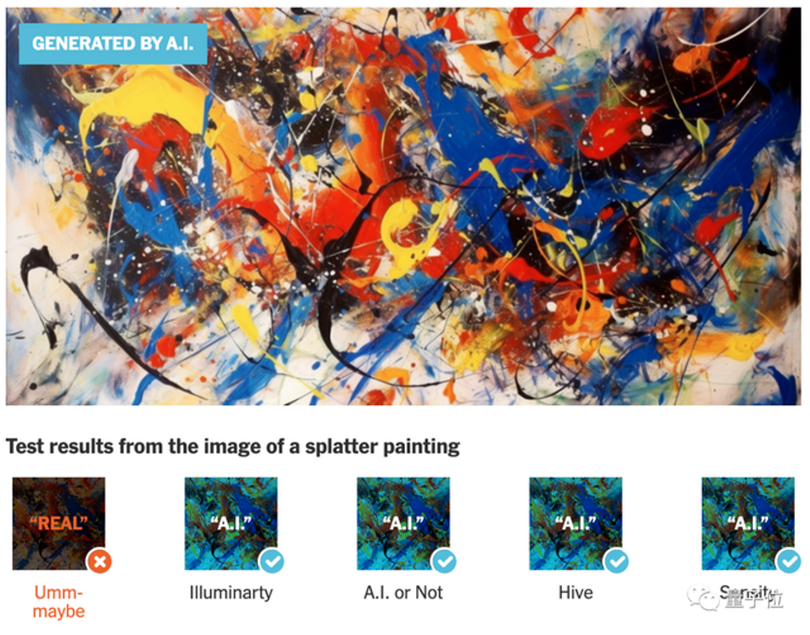

Ngoài ra, họ cũng thử nghiệm riêng các bức ảnh nghệ thuật và phát hiện ra rằng hầu hết AI discriminator phán đoán đúng ảnh được con người chụp.

So với một bức ảnh khác do AI sáng tác, 4 AI discriminator cũng đánh giá chính xác, chỉ Umm-maybe sai. Umm-maybe dường như thực sự không đáng tin cậy.

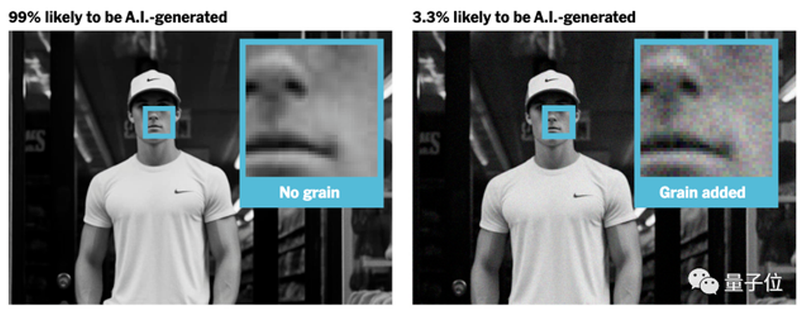

Điều đáng nói là nếu thực hiện trên hình ảnh do AI tạo ra một số động thái sửa chữa dù nhỏ, các AI discriminator cũng sẽ thất bại.

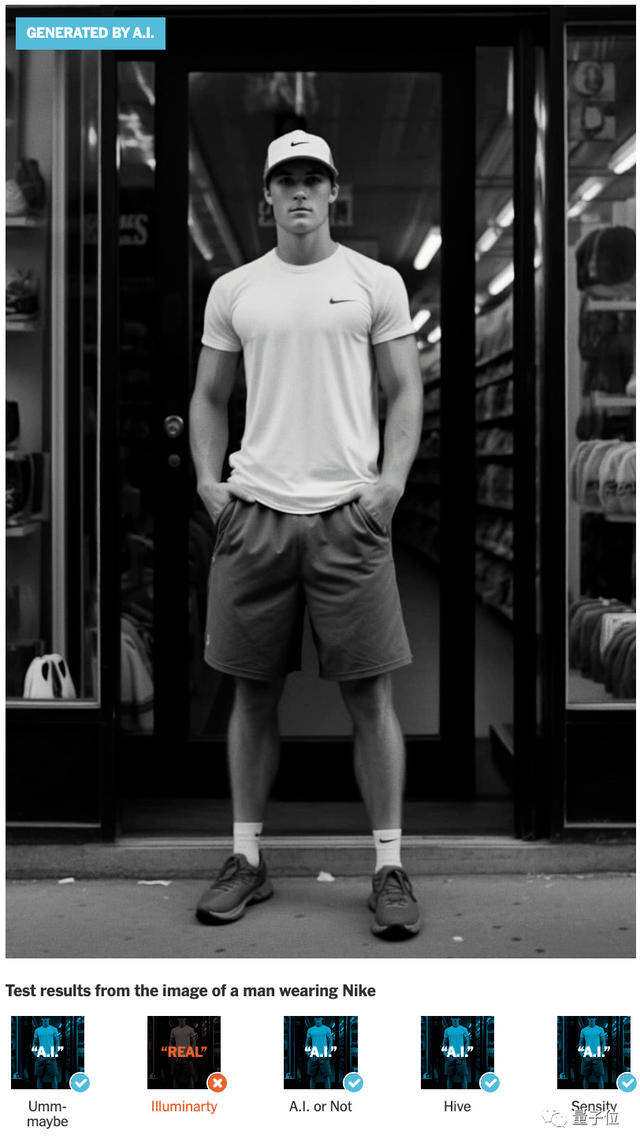

Ví dụ, trong bức ảnh về một người đàn ông mặc đồ Nike, lúc đầu 4 AI discriminator đã đánh giá nó được tạo ra bởi AI. Nhưng nếu thêm một số chi tiết dù nhỏ vào ảnh, các AI discriminator liền đánh giá hàm lượng AI của ảnh này từ 99% xuống chỉ còn 3,3%.

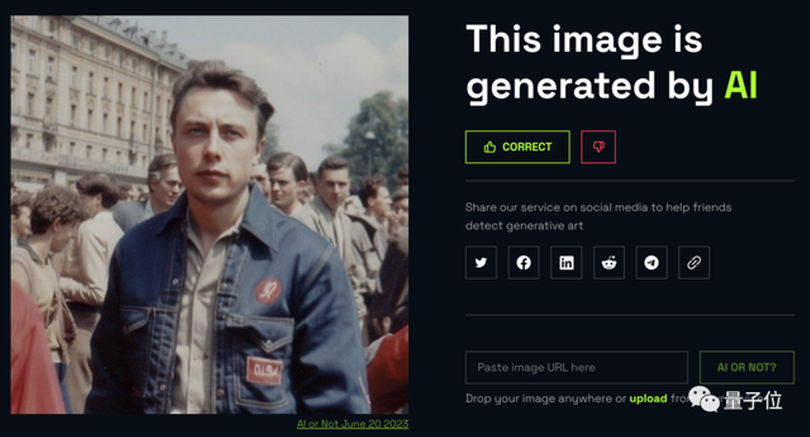

Cuối cùng, người ta cũng đã thử nghiệm một số AI discriminator đang được sử dụng. Kết quả cho thấy đối với bức ảnh "Elon Musk ở Liên Xô", Umm-maybe cho rằng có 85% xác suất là do con người tạo ra. Illuminarty cho rằng chỉ có 5,4% khả năng đó là sáng tác của AI. Chỉ có A.I or Not xác nhận đó là ảnh do AI tạo ra.

Vậy tiêu chuẩn đánh giá của AI discriminator là gì? Làm thế nào để AI phân biệt được đâu là thật đâu là giả?

Nói chung, tiêu chuẩn phán đoán của AI discriminator khác với con người. Con người thường căn cứ vào tính hợp lý của nội dung hình ảnh, còn AI lại bắt đầu từ các thông số hình ảnh, chẳng hạn như cách sắp xếp pixel, độ rõ nét và độ tương phản…

Vì vậy, điều này giải thích tại sao tất cả các AI discriminator đều cho rằng bức ảnh người khổng lồ cao 3 mét là thật.

Hơn một năm sau khi các hình ảnh AI trở nên phổ biến, nhiều AI discriminator đã xuất hiện trên thị trường.

Một số được đặt trực tiếp Hugging Face cho phép mọi người sử dụng miễn phí, trong khi một số khác đã thành lập công ty và chỉ cung cấp hình thức kết nối API.

Ví dụ Hive là công ty cung cấp giải pháp thương mại, từ kết quả test trên đây người ta có thể thấy Hive cho hiệu quả tốt nhất, với hầu hết đều đưa ra đánh giá chính xác.

Trước đó, hoạt động kinh doanh chính của họ là cung cấp dịch vụ đánh giá dữ liệu cho các trang web nền tảng, hỗ trợ hình ảnh, video và văn bản cho các nền tảng dịch vụ Reddit, Quora, v.v.

Theo QQ