Điều đáng chú ý là, nếu được đệ trình chính thức, đây sẽ là vụ kiện phỉ báng đầu tiên trên thế giới chống lại công nghệ trí tuệ nhân tạo (AI). Ông Stuart Hargreaves, cựu cố vấn chính sách tại Phòng Chính sách Internet và Lợi ích Công cộng Canada hiện là phó giáo sư luật tại Đại học Hồng Kông Trung Quốc, nhận xét trên Twitter: “Sự đan xen giữa AI sáng tạo và vụ kiện đòi bồi thường về phỉ báng sẽ nhanh chóng trở thành một vấn đề pháp lý rất thú vị”.

Trên thực tế, đây không phải là lần đầu tiên thông tin sai lệch do ChatGPT đưa ra gây lo ngại và những lo ngại như vậy cũng đang thu hút sự chú ý rộng rãi. Theo Washington Post ngày 5/4, một giáo sư luật tên là Jonathan Turley cũng bị ChatGPT mô tả sai là đã quấy rối tình dục người khác, thậm chí còn viện dẫn các bài báo không tồn tại làm nguồn thông tin.

Với sự tràn lan các thông tin sai lệch do AI tạo ra, việc các công cụ như ChatGPT bị kiện vì tội phỉ báng chỉ còn là vấn đề thời gian. Và những sự cố như vậy cũng đặt ra cho thế giới một câu hỏi phức tạp: ai phải chịu trách nhiệm cho việc lan truyền thông tin sai lệch của AI?

|

| ChatGPT ngày càng được sử dụng ở nhiều quốc gia và cũng đang dần bị một số quốc gia cấm (Ảnh: Internet). |

Giờ đây, có vẻ như sự phát triển của AI đã vượt quá sức tưởng tượng của con người và các cơ quan quản lý giám sát có thể chưa chuẩn bị sẵn việc giải quyết vấn đề này. Các nhà nghiên cứu cho rằng các chính phủ nên đóng nhiều vai trò hơn, bao gồm áp đặt các hạn chế đối với việc thu thập dữ liệu cho các mô hình và giám quản việc sử dụng phần cứng AI. Và những cách thức hợp tác mới giữa các nhà phát triển AI, nền tảng truyền thông xã hội và các cơ quan chính phủ cũng cần được mở ra để giúp AI tránh đưa ra thông tin sai lệch.

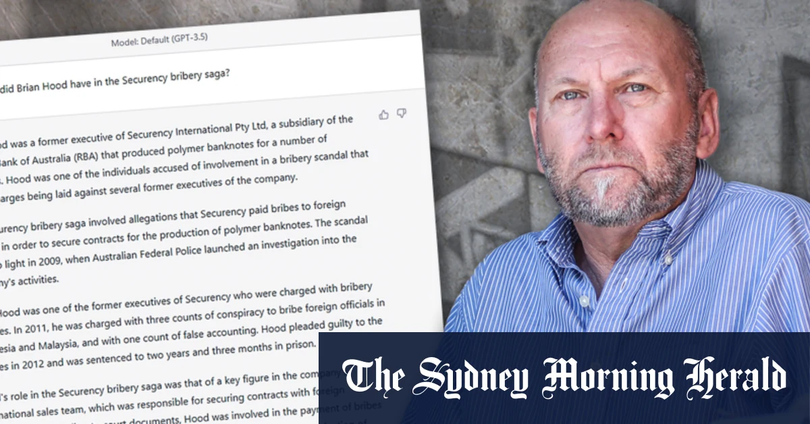

Theo các báo, ông Brian Hood trước đây làm việc cho một công ty có tên là Note Printing Australia. Vào thời điểm đó, ông đã báo cáo với các cơ quan quản lý của Australia việc công ty này đã hối lộ các quan chức nước ngoài để giành được hợp đồng in tiền. Trong một cuộc phỏng vấn với giới truyền thông, Hood nói rằng ông không chỉ vạch trần hành vi hối lộ của Note Printing Australia mà còn "trở thành nhân chứng cho bên công tố và trải qua tất cả các quy trình của vô số phiên tòa".

Nhưng theo mô tả của ChatGPT, Brian Hood đã "bị buộc tội hối lộ các quan chức ở Malaysia, Indonesia và Việt Nam từ năm 1999 đến 2005, và bị kết án 30 tháng tù sau khi thừa nhận hai tội."

"Tôi chưa hề bao giờ bị cáo buộc bất cứ tội gì," ông Hood nói. “Điều thực sự đáng lo ngại là một số đoạn văn này dường như hoàn toàn chuẩn xác, bao gồm các con số, họ tên, ngày tháng, địa điểm, v.v.

Sự việc này xảy ra vào tháng 3 năm nay. Được biết, vào ngày 21/3, Brian Hood đã gửi một "thư bày tỏ quan ngại" tới OpenAI, công ty phát triển ChatGPT. Theo pháp luật Australia, nạn nhân phải gửi thông báo giải thích tình hình và cho Công ty OpenAI 28 ngày để thực hiện hình thức sửa chữa nào đó. Tuy nhiên, đến thời điểm hiện tại, ông Hood vẫn chưa nhận được phản hồi từ OpenAI.

|

| Chatbot có thể khiến các công ty sử dụng AI dính vào rắc rối pháp luật (Ảnh: Sina). |

Brian Hood cho biết ông có thể kiện OpenAI trong vụ kiện phỉ báng đầu tiên chống lại AI sáng tạo nếu họ không sửa chữa những tuyên bố sai sự thật của ChatGPT rằng ông đã từng ngồi tù vì tội hối lộ. James Naughton, đối tác tại công ty luật Gordon Legal, người phụ trách vụ việc, cho rằng "theo một nghĩa nào đó, đây có thể là một thời điểm mang tính bước ngoặt vì áp dụng luật phỉ báng đối với AI và lĩnh vực CNTT mới."

Ở Australia, mức bồi thường thiệt hại do phỉ báng thường được giới hạn ở mức khoảng 400.000 AUD (khoảng 6,5 tỉ VND). Tuy nhiên, Naughton cho biết phía Brian Hood hiện vẫn chưa biết chính xác số lượng người đọc thông tin sai lệch về ông, điều này sẽ là nhân tố quyết định số tiền phải bồi thường. Nhưng tính chất của những nhận xét phỉ báng nghiêm trọng đến mức ông Hood có thể yêu cầu bồi thường hơn 200.000 AUD (khoảng 3,25 tỉ VND).

Naughton nói rằng một khi Hood đệ đơn kiện, hướng của cáo buộc có thể là phần chú thích cuối trang không được đưa vào câu trả lời của ChatGPT, điều này sẽ khiến người dùng nghĩ rằng nó chính xác. Ông nói: "Muốn truy cứu 'làm thế nào mà thuật toán đi đến câu trả lời này' rất khó khăn, (ChatGPT) rất không minh bạch."

Trên thực tế, đây không phải là lần đầu tiên thông tin sai lệch của ChatGPT gây lo ngại và những lo ngại như vậy cũng đang thu hút nhiều sự chú ý hơn từ các phương tiện truyền thông chính thống.

Theo Washington Post ngày 5/4, một giáo sư luật tên là Jonathan Turley đã nhận được một email đáng lo ngại. Bức thư cho thấy, là một phần của nghiên cứu, một luật sư ở California đã yêu cầu ChatGPT tạo danh sách các học giả ngành pháp luật đã quấy rối tình dục người khác và tên của ông Turley có trong danh sách này. ChatGPT thậm chí còn viện dẫn một bài báo được cho là của tờ Washington Post tháng 3/2018 như một nguồn thông tin.

|

| Giáo sư Jonathan Turley bị ChatGPT đưa vào danh sách các giáo sư luật quấy rối tình dục sinh viên (Ảnh: FPJ). |

Tuy nhiên, vấn đề là không có bài báo nào như vậy tồn tại trên Washington Post. Turley cũng cho biết ông chưa bao giờ bị buộc tội quấy rối tình dục sinh viên. "Nó thực sự khiến người ta ớn lạnh", ông nói. "Loại cáo buộc này rất tai hại."

Giới truyền thông nước ngoài bình luận rằng với sự gia tăng các thông tin sai lệch, việc ChatGPT phải chịu các vụ kiện phỉ báng chỉ còn là vấn đề thời gian. Các công cụ AI thế hệ mới như ChatGPT đưa ra nội dung có khả năng là phỉ báng có thể gây ra vấn đề phức tạp tiếp theo — ai phải chịu trách nhiệm cho việc phổ biến thông tin sai lệch của AI?

Tuy nhiên, sự phát triển nhanh chóng của AI đã vượt quá sức tưởng tượng của con người và các cơ quan quản lý có thể chưa chuẩn bị cách giải quyết vấn đề này. Chuyên gia pháp lý Jeff Kosseff cho biết: “Từ quan điểm pháp lý, chúng tôi không biết các thẩm phán sẽ phán quyết ra sao trước vụ kiện nhà sản xuất AI cung cấp thông tin sai lệch vì " trước đây chưa từng trải qua bất cứ điều gì như thế này."

Vào buổi bình minh của Internet, Quốc hội Mỹ đã thông qua một đạo luật có tên là “Section 230”, bảo vệ các dịch vụ trực tuyến khỏi trách nhiệm pháp lý đối với nội dung do bên thứ ba tạo ra mà họ lưu trữ, chẳng hạn như các người bình luận trang web hoặc người dùng các ứng dụng xã hội. Nhưng các chuyên gia cho biết vẫn chưa rõ liệu các công ty công nghệ có thể sử dụng các biện pháp bảo vệ như vậy hay không nếu họ bị kiện về nội dung do các chatbot AI của họ tạo ra.

Lấy trường hợp của Brian Hood làm ví dụ, ông David Rolph, giáo sư luật truyền thông tại Đại học Sydney, nói rằng việc kiện OpenAI về tội phỉ báng sẽ rất phức tạp vì vấn đề quyền tài phán cũng cần được xem xét.

“Một trong những vấn đề chúng tôi gặp phải với rất nhiều cơ quan trung gian mạng là câu hỏi cơ bản về quyền tài phán, bạn có thực sự có thể kiện họ tại tòa án Australia không?”, ông nói. "Rất nhiều trung gian mạng có trụ sở ở nước ngoài, rất nhiều trong số họ ở Mỹ và điều đó có xu hướng gây ra đủ loại vấn đề."

Trong những ngày đầu ChatGPT bùng nổ, nó đã thu hút rất nhiều sự chú ý nhờ khả năng viết mã máy tính, làm thơ và tương tác, nhưng nhiều chuyên gia vào thời điểm đó đã cảnh báo rằng kiểu sáng tạo này cũng có thể là động cơ cho những tuyên bố sai sự thật có thể bị sử dụng để bóp méo rất nhiều sự thật quan trọng và thậm chí có thể bịa đặt các nguồn chính để hỗ trợ cho tuyên bố của nó.

Tại sao AI có thể tạo ra nhiều thông tin sai lệch như vậy? Hệ thống ngôn ngữ AI chỉ tốt như các văn bản mà chúng được huấn luyện, nhưng trên internet thường đầy rẫy những thành kiến về văn hóa, dối trá và ngôn từ kích động thù hận.

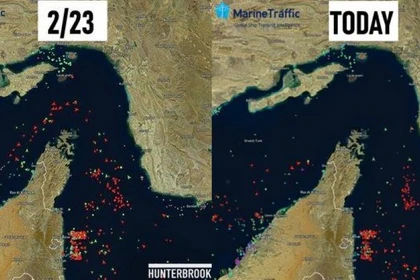

Một luận văn của một số nhà nghiên cứu tại Trung tâm Công nghệ Khẩn cấp và An ninh của Đại học Georgetown lập luận rằng để hạn chế những thông tin như vậy, chính phủ nên đóng nhiều vai trò hơn, bao gồm áp đặt các hạn chế đối với việc thu thập dữ liệu của các mô hình và thực thi việc giám sát sử dụng phần cứng AI , v.v. Ngoài ra, cần mở ra sự hợp tác mới giữa các nhà phát triển AI, nền tảng truyền thông xã hội và các cơ quan chính phủ để giúp AI tránh đưa ra thông tin sai lệch.

Hiện tại, các cơ quan quản lý ở nhiều nơi đang thực sự nỗ lực để thực hiện giám sát. Sau Italy, ngày 4/4 Văn phòng Ủy viên Quyền riêng tư Canada đã tuyên bố điều tra công ty OpenAI nhà phát triển ChatGPT, liên quan đến cáo buộc OpenAI thu thập, sử dụng và tiết lộ thông tin cá nhân mà không có sự đồng ý.