Nhiều quyết định quan trọng với con người đã và đang được đưa ra thông qua các cơ chế và công cụ AI, ví dụ như công ty bảo hiểm từ chối thanh toán các khoản bảo hiểm sức khỏe dựa trên thuật toán đánh giá rủi ro, hay cảnh sát quyết định bắt giữ nhiều cá nhân do nghi ngờ lên kế hoạch phạm tội dựa trên một mô hình dự báo từ siêu máy tính xử lý dữ liệu.

Đây đều là những viễn cảnh mà ngành công nghệ đang quan ngại về những bước tiến mạnh mẽ của trí tuệ nhân tạo trong nhiều mặt của xã hội. AI đang được thử nghiệm với nhiều lĩnh vực như nghiên cứu và chẩn đoán y tế, phương tiện tự hành, giám sát an ninh, định hướng mục tiêu quốc phòng hay xử lý tội phạm. Một báo cáo gần đây của hãng PwC dự báo AI có thể thúc đẩy nền kinh tế toàn cầu tăng thêm 15,7 nghìn tỷ USD cho đến năm 2030.

Tuy nhiên, những thuật toán phần mềm đó đang ngày càng trở nên phức tạp đến mức chính những người sáng tạo ra chúng còn không hiểu hết được cách thức chúng đưa ra những câu trả lời như vậy.

(Nguồn: BBC)

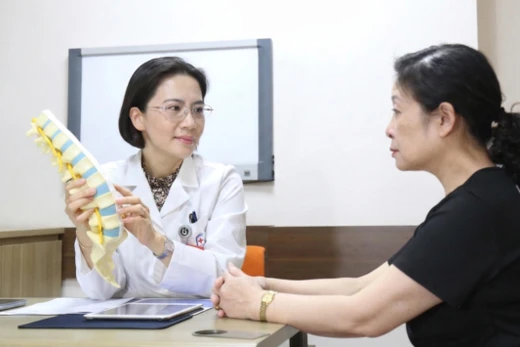

Mạng nơ ron (neural network) được thiết kế để tái tạo lại cách não người suy nghĩ thông qua số lượng lớn bộ xử lý và khối lượng khổng lồ dữ liệu, bằng việc phát hiện các mô hình hay khuôn mẫu giữa hàng triệu biến số với máy học, và quan trọng, điều chỉnh phản ứng với những gì chúng được đào tạo. Chính khả năng này cho phép nghiên cứu sâu hơn và đưa ra các dự báo chính xác về thời tiết hoặc chẩn đoán bệnh ung thư.

Mặc dù vậy, không ít các chuyên gia cũng cảnh báo rằng, những bước tiến nhanh nhất trong nghiên cứu AI gần đây đang tập trung vào phương thức tiếp cận dựa vào dữ liệu và kiểm thử hộp đen. Nếu các hệ thống được sử dụng cho hoạt động bầu cử hoặc dịch vụ công, sẽ nảy sinh nhiều vấn đề do tương tác trong mạng nơ ron vô cùng phức tạp và khó khăn để giải thích và sửa đổi.

Một xu hướng mới trong ngành công nghiệp robot là học tăng cường sâu (deep reinforcement learning) khi mà nhà thiết kế chỉ đơn giản vạch ra các mục tiêu hành vi của hệ thống và nó tự động học hỏi bằng các tương tác trực tiếp với môi trường. Điều này dẫn tới hệ quả một hệ thống còn khó hiểu hơn. Do vậy các nhà nghiên cứu lại đang phải tìm hiểu các cách để giải mã thuật toán và đặt chúng dưới quyền kiểm soát của con người. Ví dụ, Cơ quan chỉ đạo các dự án quốc phòng tiên tiến Hoa Kỳ (DARPA) vận hành dự án Explainable AI và Open AI - một công ty nghiên cứu phi lợi nhuận - đang cùng chung tay tìm hiểu và triển khai con đường dẫn tới AI an toàn. Điều này có vẻ nhạy cảm, nhưng một trong những lợi thế của AI là làm được những điều mà con người không thể làm được. Liệu chúng ta có đang can thiệp và làm giảm hiệu quả của nó bằng việc đi sâu tìm hiểu bên trong.

Adrian Weller, Giám đốc chương trình AI tại Viện Nghiên cứu Alan Turing (Anh), gợi ý về nhu cầu tìm hiểu cách thức máy móc đưa ra quyết định còn phụ thuộc vào mức độ quan trọng của những quyết định đó ra sao. Và một vài cân nhắc cũng có thể quan trọng hơn cả tính có thể giải thích được đó. "Nếu như chúng ta có thể chắc chắn một hệ thống đang hoạt động đáng tin cậy, không có sự phân biệt và an toàn, những điều đó có thể đáng cân nhắc hơn cả việc chúng ta cần phải hiểu cách hoạt động của nó như thế nào", vị chuyên gia này cho biết. "Đối với những chẩn đoán y khoa, sẽ là rất tốt khi tỷ lệ chính xác đang ở mức 95% trung bình. Nhưng nếu tôi vẫn muốn biết cách tính toán của hệ thống AI cho riêng trường hợp của tôi, tính có thể giải trình được sẽ trở nên cần thiết hơn".

Andrian Weller, Giám đốc chương trình AI tại Viện Alan Turing (Nguồn: BBC)

Mặt khác, khi AI được sử dụng để hỗ trợ đưa ra án phạt tù giam, rõ ràng cách thức nhận định và đưa ra quyết định phải rõ ràng. Weller cho biết: "Nếu một thuật toán khuyến nghị một người nhận bản án 5 năm tù giam, người đó sẽ muốn một lời giải thích rõ ràng về việc tuân thủ đúng quy trình và quy định pháp luật, cũng như được tạo cơ hội thử thách thuật toán mà người đó cho là không đúng. Tôi đồng ý với những ý kiến yêu cầu các công ty công nghệ làm rõ cách thức thuật toán hoạt động. Nếu không có những biện pháp bảo vệ, sẽ có nguy cơ con người chúng ta bị phân biệt đối xử mà không biết lý do".

Theo ICT News